![]() Ранее мы рассматривали пример построения фермы Remote Desktop Connection Broker (RDCB) на базе Windows Server 2008 R2. С выходом Windows Server 2012 технологии повышения доступности для служб RDS претерпели определённые изменения, в частности теперь для построения отказоустойчивой фермы RDCB не используются механизмы Windows Failover Cluster. В этой заметке мы попробуем рассмотреть процедуру создания новой фермы RDCB на базе Windows Server 2012 с применением Windows NLB, как средства повышения доступности и балансировки сетевой нагрузки для ролей RD Connection Broker и RD Web Access. После создания фермы RDCB выполним ряд настроек, которые позволят нам считать инфраструктуру RDS минимально подготовленной к использованию в соответствии со следующим планом:

Ранее мы рассматривали пример построения фермы Remote Desktop Connection Broker (RDCB) на базе Windows Server 2008 R2. С выходом Windows Server 2012 технологии повышения доступности для служб RDS претерпели определённые изменения, в частности теперь для построения отказоустойчивой фермы RDCB не используются механизмы Windows Failover Cluster. В этой заметке мы попробуем рассмотреть процедуру создания новой фермы RDCB на базе Windows Server 2012 с применением Windows NLB, как средства повышения доступности и балансировки сетевой нагрузки для ролей RD Connection Broker и RD Web Access. После создания фермы RDCB выполним ряд настроек, которые позволят нам считать инфраструктуру RDS минимально подготовленной к использованию в соответствии со следующим планом:

- Среда исполнения

- Подготавливаем виртуальные сервера

- Создаём кластер NLB

- Подготавливаем SQL Server

- Устанавливаем роли Remote Desktop Services

- Создаём высоко-доступный RD Connection Broker

- Добавляем сервера в высоко-доступный RD Connection Broker

- Добавляем на сервера роль RD Web Access

- Создаём коллекцию сеансов – Session Collection

- Настраиваем цифровые сертификаты

- Настраиваем веб-узлы RD Web Access

- Настраиваем Roaming User Profiles и Folder Redirection

- Публикуем приложения RemoteApp

- Устанавливаем языковой пакет

- Настраиваем перенаправление печати

Среда исполнения

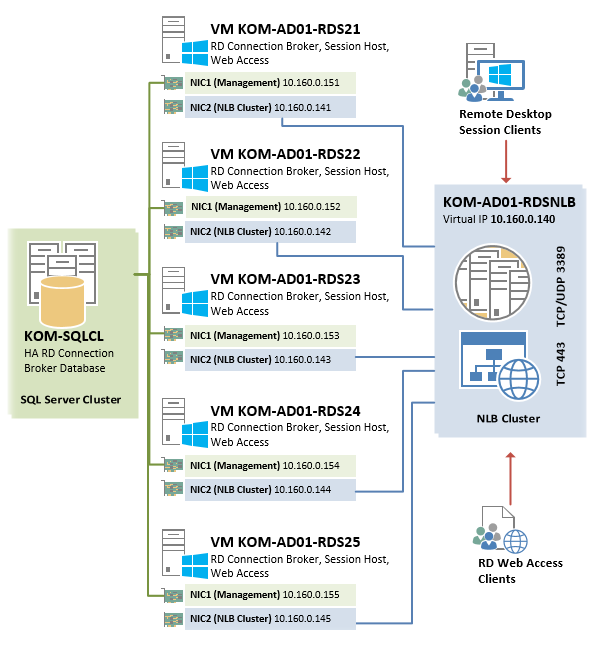

В рассматриваемом примере мы будем строить ферму RDCB из 5 виртуальных серверов одинаковой конфигурации на базе Hyper-V из Windows Server 2012 Datacenter EN. На всех виртуальных серверах устанавливается Windows Server 2012 Standard EN.

Каждый из виртуальных серверов будет иметь по два сетевых интерфейса, настройка которых будет рассмотрена далее.

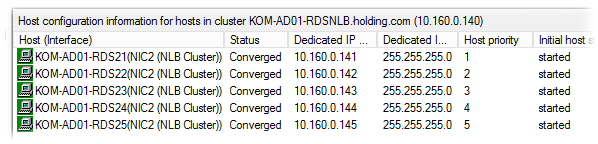

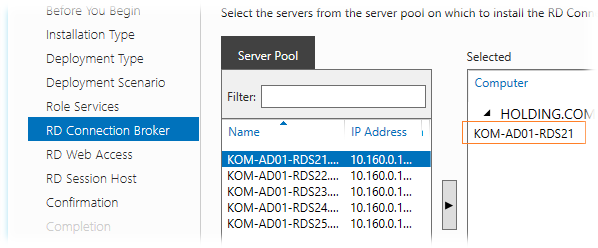

Серверам присвоены имена – KOM-AD01-RDS21 , KOM-AD01-RDS22 , KOM-AD01-RDS23 , KOM-AD01-RDS24 , KOM-AD01-RDS25

Создаваемый в процессе описания высоко-доступный экземпляр RD Connection Broker а также NLB-кластер RD Web Access будут использовать общее виртуальное имя KOM-AD01-RDSNLB.

База данных высоко-доступного экземпляра RDCB будет расположена на отдельном кластере SQL Server c именем KOM-SQLCL

С точки зрения сетевого взаимодействия, упрощённая схема отказоустойчивой фермы RDS в нашем случае будет выглядеть следующим образом:

Подготавливаем виртуальные сервера

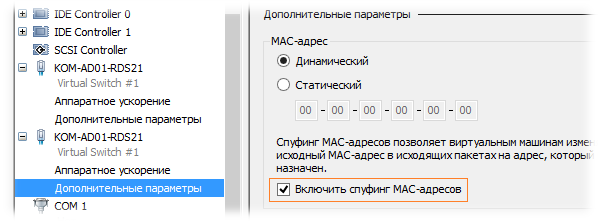

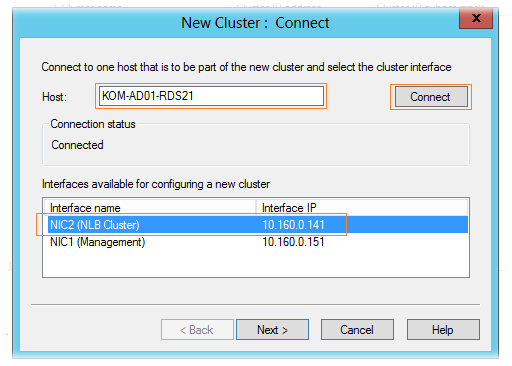

Итак, у каждого виртуального сервера создадим по 2 сетевых адаптера. Назовём их условно на каждом сервере таким образом, чтобы было понятно за что отвечает этот интерфейс - NIC1 (Management) и NIC2 (NLB Cluster).

При создании второго сетевого адаптера NIC2, который будет использоваться для построения NLB в свойствах виртуальной машины Hyper-V необходимо разрешить спуфинг МАС адресов (Enable spoofing of MAC addresses)

Согласно нашей схемы, выделим и распределим статические IP адреса на серверах следующим образом:

| Имя сервера | Настройки IP NIC1 | Настройки IP NIC2 (NLB Cluster) |

| KOM-AD01-RDS21 | IP 10.160.0.151/24 | IP 10.160.0.141/24 |

| KOM-AD01-RDS22 | IP 10.160.0.152/24 | IP 10.160.0.142/24 |

| KOM-AD01-RDS23 | IP 10.160.0.153/24 | IP 10.160.0.143/24 |

| KOM-AD01-RDS24 | IP 10.160.0.154/24 | IP 10.160.0.144/24 |

| KOM-AD01-RDS25 | IP 10.160.0.155/24 | IP 10.160.0.145/24 |

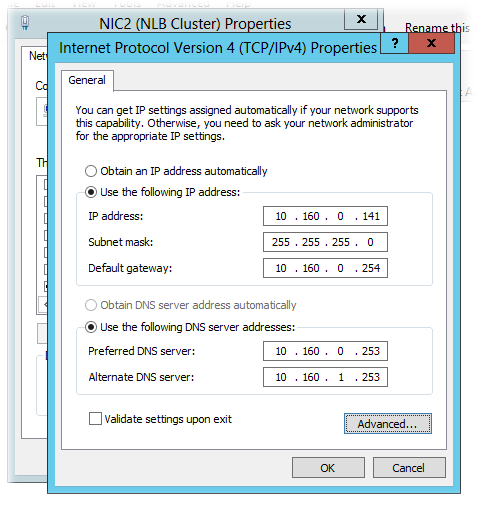

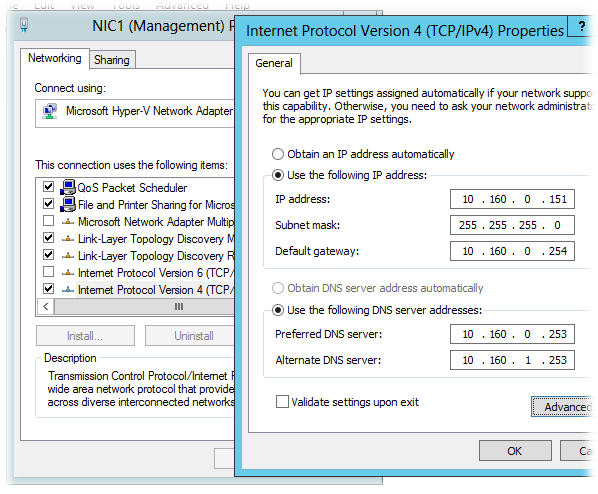

На всех интерфейсах используются одинаковые настройки адреса шлюза по умолчанию -10.160.0.254 и адресов DNS - 10.160.0.253, 10.160.1.253. Причина использования именно такой сетевой конфигурации для построения NLB на базе Windows Server 2012 была ранее изложена в заметке App-V 5 for RDS — Разворачиваем инфраструктуру повышенной доступности

Интерфейс NIC1 будет отвечать за управление самим сервером (будет зарегистрирован в DNS на FQDN имя сервера), а NIC2 (для которого включён спуфинг MAC адресов) будет участником NLB кластера. Выполним настройку сетевых интерфейсов на каждом из серверов согласно вышеприведённой таблицы на примере сервера KOM-AD01-RDS21

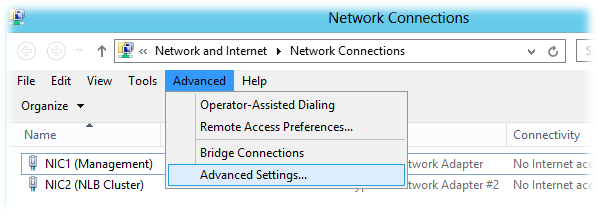

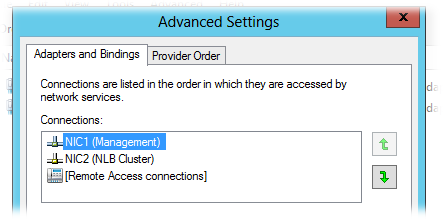

Откроем окно настройки сетевых подключений и в меню Advanced > Advanced Settings и проверим порядок использования подключений (Connections).

NIC1 должен иметь приоритет над NIC2.

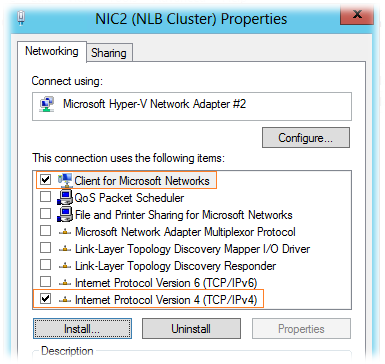

В свойствах сетевого подключения, которое будет использоваться для подключения к NLB кластеру (NIC2) можно отключить все компоненты, за исключением TCP/IPv4 и Client for Microsoft Networks:

В свойствах компонента TCP/IPv4 зададим настройки согласно приведённой ранее таблицы и по кнопке Advanced откроем окно дополнительных настроек

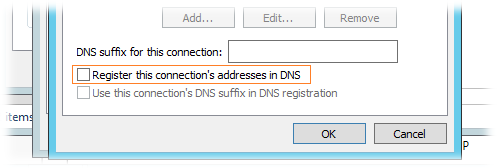

В окне дополнительных настроек TCP/IP на закладке DNS отключим механизм регистрации в DNS:

Интерфейс NIC1 настроим согласно вышеприведённой таблицы аналогичным образом, за исключением того, что на нём может быть включена опция регистрации в DNS и обязательно должны быть включены компоненты TCP/IPv4 , Client for Microsoft Networks и File and Printer Sharing for Microsoft Networks

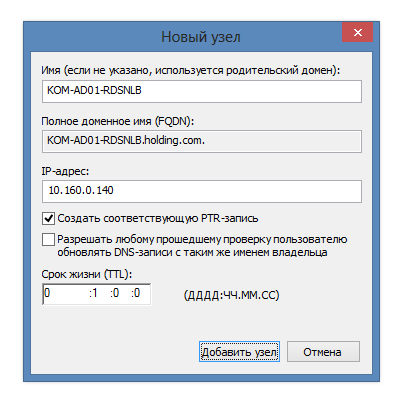

После того как описанным способом настроены сетевые интерфейсы на всех серверах, зарегистрируем их имена в доменной зоне прямого просмотра DNS (если запрещена динамическая регистрация в DNS и/или отключена опция регистрации в свойствах интерфейсов NIC1). Для пакетной регистрации A-записей в DNS можно воспользоваться скриптом описанным в заметке DNS – Пакетное создание А-записей с помощью WMI и Powershell

Дополнительно сразу же создаём статическую А-запись для будущего NLB кластера.

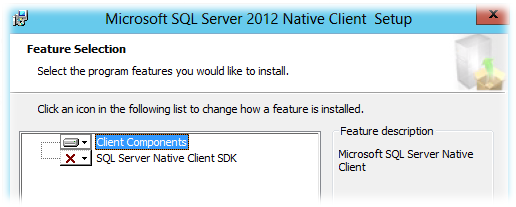

RD Connection Broker использует для хранения БД сессий общий экземпляр SQL Server, поэтому все сервера RDCB должны иметь "на борту" клиентские компоненты SQL Server, а также привилегии доступа к SQL Server. Настройку доступа к SQL Server выполним позже, а пока установим на каждый сервер, где планируется развертывание RD Connection Broker, свежую версию пакета Microsoft SQL Server 2012 Native Client (в нашем случае установка нужна на всех пяти виртуальных серверах). Скачать его можно со страницы загрузки Microsoft SQL Server 2012 SP1 Feature Pack (файл sqlncli.msi)

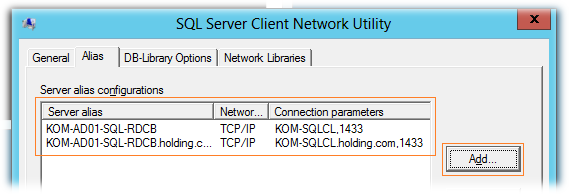

После установки клиента SQL Server создадим на каждом сервере SQL-Alias, который будем в дальнейшем использовать для подключения серверов RDCB к серверу SQL Server. Этого конечно можно и не делать, но это может оказаться полезным (даст нам дополнительную гибкость) в случае необходимости переноса БД на другой SQL-сервер или даже экземпляр. Запустим встроенную в ОС утилиту SQL Server Client Network Utility (C:\windows\system32\cliconfg.exe) и добавим два новых алиаса – с коротким именем сервера и FQDN

Фактически созданные SQL-алиасы в интерфейсе утилиты были записаны в ключ реестра HKLM\SOFTWARE\Microsoft\MSSQLServer\Client\ConnectTo

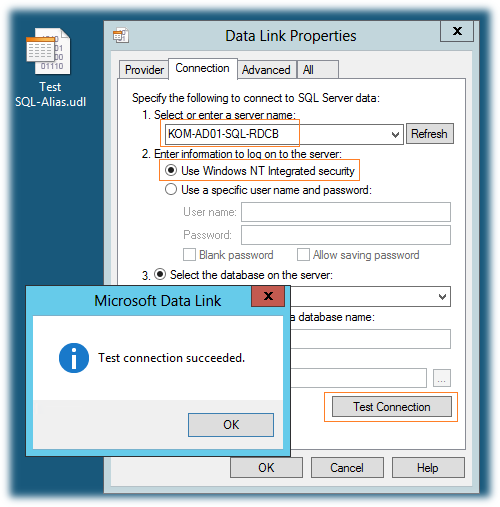

Теперь нужно проверить созданные нами SQL-алиасы. Для этого создадим пустой файл Universal Data Link с расширением *.udl и запустим его. На закладке Connection укажем SQL-алиас, выберем режим аутентификации Use Windows NT Integrated security и нажмём кнопку Test Connection

Если мы всё сделали правильно, то получим положительный результат подключения. При этом перечень всех активных БД на новом SQL сервере будет доступен в выпадающем списке Select the database on the server. Таким образом проверим алиас созданный как по NetBIOS имени так и по FQDN.

***

Далее, с помощью PowerShell установим на каждый сервер исполняемые компоненты NLB

Import-Module "ServerManager" Add-WindowsFeature "NLB" -IncludeManagementTools

Создаём кластер NLB

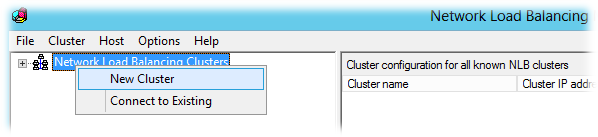

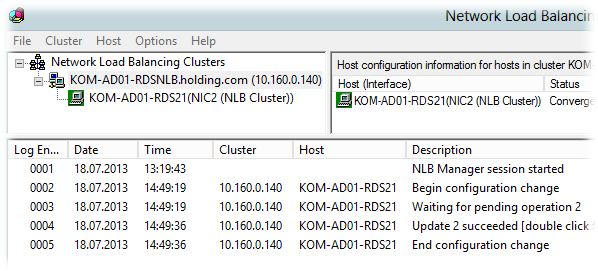

На первом виртуальном сервере (KOM-AD01-RDS21) открываем консоль Network Load Balancing Manager (nlbmgr.exe). Выбираем пункт меню Cluster > New Cluster

Вводим имя первого узла, который хотим добавить в NLB, кнопкой Connect подключаемся к нему, и получив с него набор доступных интерфейсов, выбираем тот который хотим сделать участником кластера:

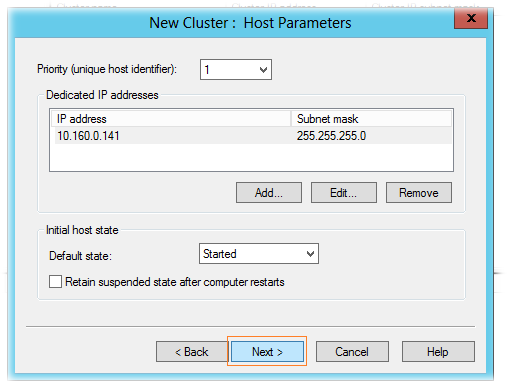

На странице параметров хоста (Host Parameters) оставляем настройки по умолчанию:

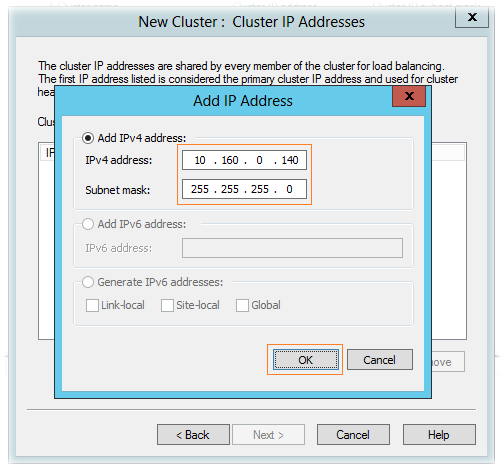

В следующем окне мастера создания кластера добавляем IP адрес NLB кластера, на который мы ранее в DNS зарегистрировали А-запись.

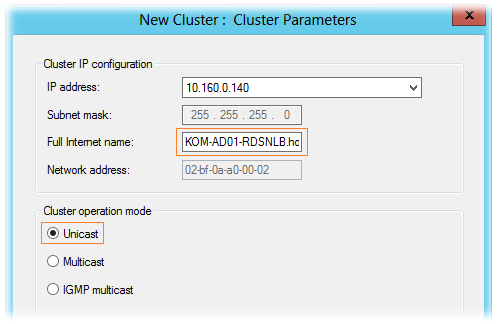

Далее указываем FQDN кластера NLB (по той самой A-записи), а также режим его работы. Режим работы кластера – режим одноадресной рассылки – Unicast.

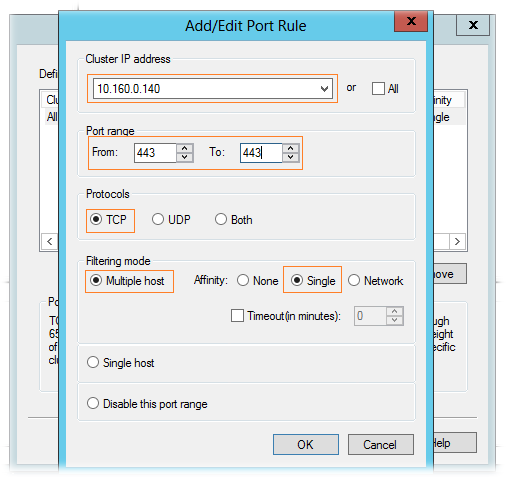

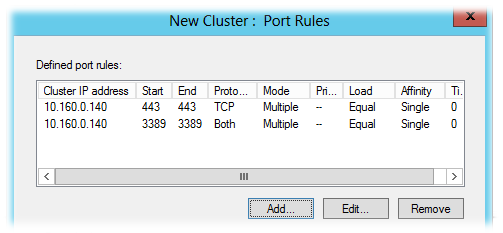

На странице правил портов (Port rules) удаляем имеющееся по умолчанию правило и добавляем необходимые нам правила. При добавлении правила портов убираем флажок All и указываем конкретный интерфейс NLB и диапазон портов, который хотим добавить в кластер NLB.

В общей сложности, в нашем примере балансировке в NLB кластере мы будем подвергать следующие порты:

TCP 443 – для подключения клиентов к RD Web Access;

TCP/UDP 3389 – для подключения клиентов к RD Connection Broker/Session Host;

Все необходимые параметры кластера заданы, создаем его по нажатию кнопки Finish и после первоначальной инициализации, если в конфигурации не допущены ошибки, NLB кластер запуститься в конфигурации с одним узлом

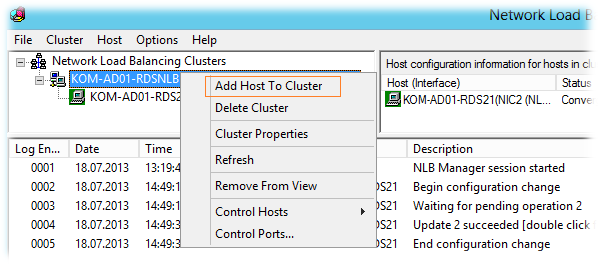

Далее, переходим на имя NLB кластера и пунктом меню Add Host to Cluster вызываем мастер добавления второго и последующих серверов в кластер.

В конечном итоге после добавления (по аналогии с первым узлом) всех серверов мы получим работоспособный Windows NLB кластер

С помощью Ping -t проверяем из клиентской подсети доступность кластерного интерфейса по очереди перезагружая узлы кластера, а затем друг за другом выключая их до тех пор пока в кластере не останется один живой узел.

Подготавливаем SQL Server

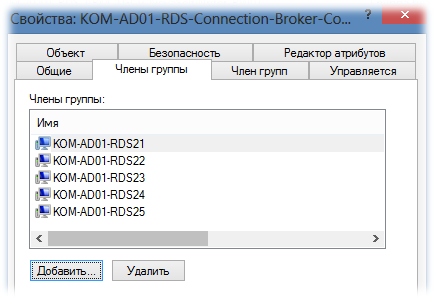

Создадим в AD группу безопасности, например KOM-AD01-RDS-Connection-Broker-Computers, и включим в нее учетные записи наших виртуальных серверов.

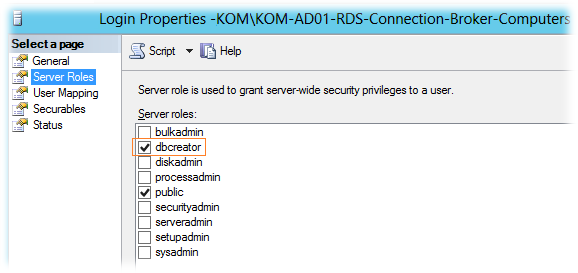

После этого подключимся к экземпляру SQL Server на котором будет размещаться БД RDCB (в нашем случае это отдельный кластер SQL Server из двух серверов), создадим новый SQL Login с привязкой к указанной доменной группе. При создании SQL-логина ему будет присвоена серверная роль SQL Server – public, которая даст право подключаться к экземпляру SQL Server. Включим ещё одну серверную роль – dbcreator. Эта роль понадобится нам лишь на время первоначальной инициализации БД RDCB для того, чтобы учетная запись сервера, на котором мы будем запускать процесс создания отказоустойчивого RDCB, смогла выполнить операцию создания новой БД.

Дополнительно на SQL сервере создадим каталог для файлов базы данных RDCB. В нашем случае это будет каталог U:\SQLData_SQL01_RDCB на кластерном диске SQL сервера.

Устанавливаем роли Remote Desktop Services

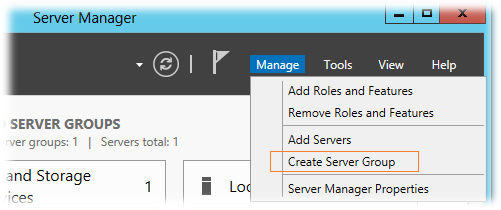

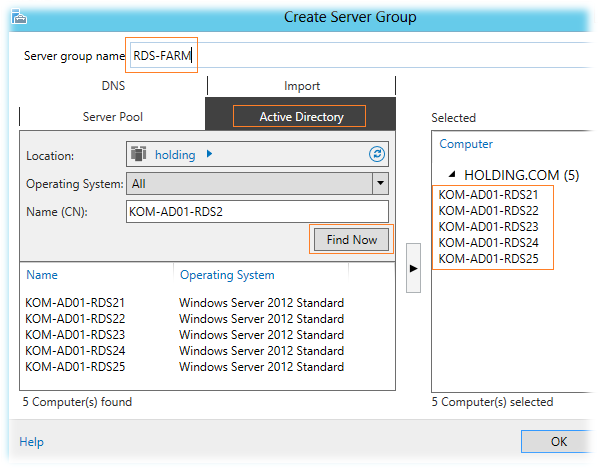

Так как консоль Server Manager в Windows Server 2012 поддерживает групповую настройку сразу нескольких серверов, перед тем как разворачивать на наши виртуальные сервера роли RDS, объединим их в логическую группу. На любом из виртуальных серверов, например на KOM-AD01-RDS21, откроем консоль Server Manager и выберем пункт меню Manage > Create Server Group

добавим пять наших виртуальных серверов в группу и дадим ей название, например RDS-FARM.

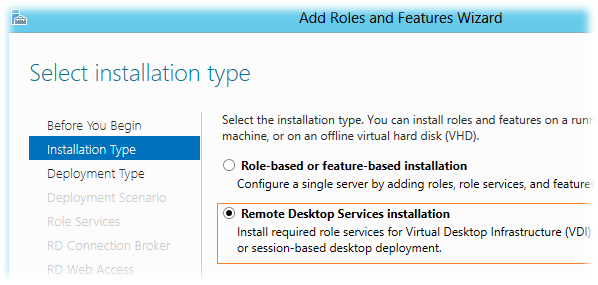

После этого выберем пункт меню Manage > Add Roles and Features Wizard

В открывшемся мастере добавления ролей выберем режим установки служб RDS - Remote Desktop Services installation

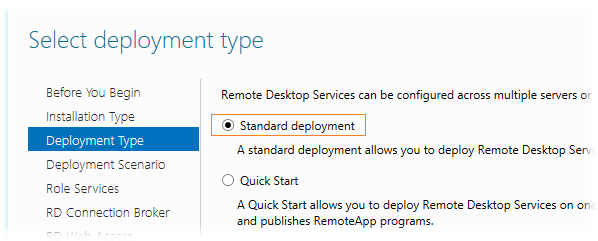

Тип развёртывания - Standard deployment

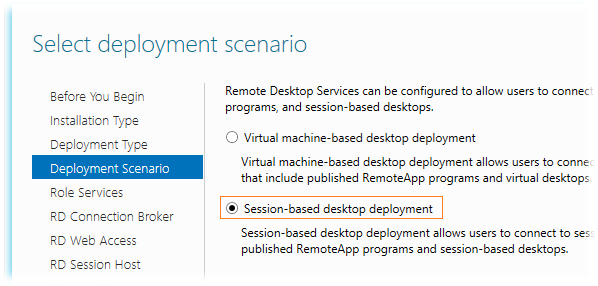

Сценарий развертывания выбираем Session-based desktop deployment, так как планируется развертывание серверов сеансов, а не серверов инфраструктуры VDI

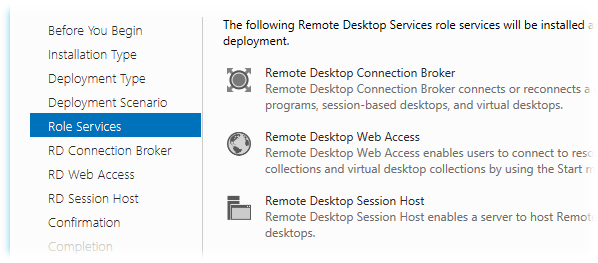

На этапе выбора ролей RDS нас предупредят о том, что будет выполняться развертывание сразу трёх ролей - RD Connection Broker, RD Session Host, RD Web Access, не оставляя при этом нам никакого выбора…

На этапе выбора серверов для роли RD Connection Broker выбираем один сервер, ибо мастер не даст нам выбрать более одного сервера. Так как всю первоначальную настройку мы выполняем на сервере KOM-AD01-RDS21, то соответственно и выберем его для этой роли…

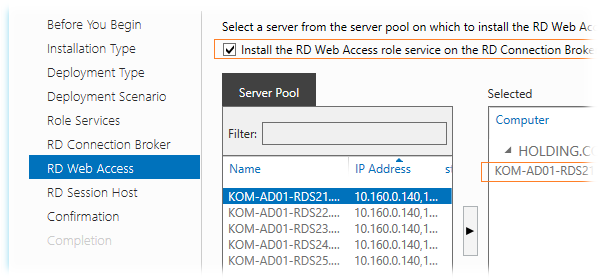

На этапе выбора серверов для роли RD Web Access включим опцию Install the RD Web Access role on the RD Connection Broker server для того чтобы эта роль была установлена на тот же сервер, который был выбран для роли RDCB. Выбирать какой-то другой сервер в нашей ситуации особого смысла нет, да и потом мастер опять таки не даст нам выбрать для установки этой роли более чем один сервер…

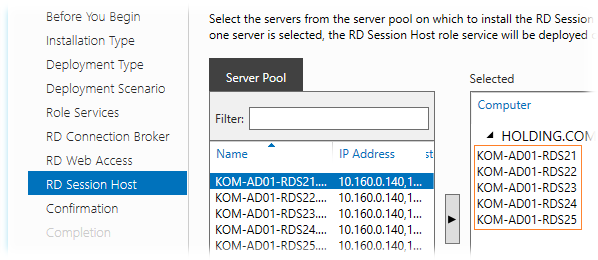

На этапе выбора серверов для роли RD Session Host мы сможем выбрать все сервера…

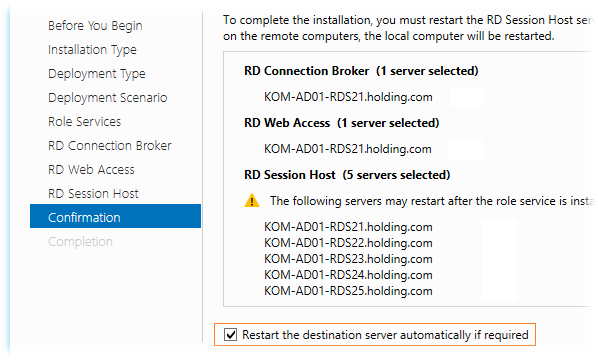

На странице подтверждения мы видим предупреждение, что серверы могут быть перезагружены после установки роли RD Session Host. Включим опцию автоматической перезагрузки серверов - Restart the destination server automatically if required и запустим процесс развёртывания..

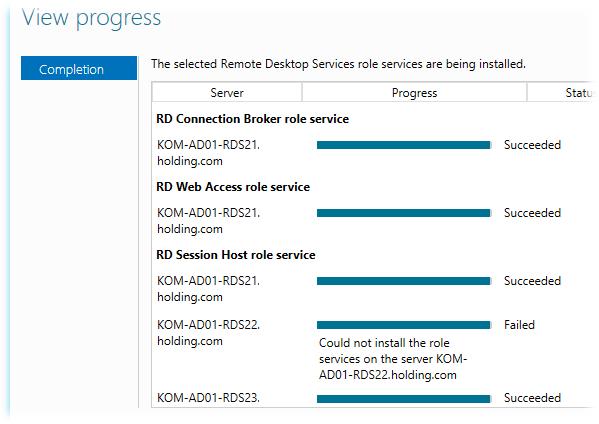

В процессе установки ролей первым будет автоматически перезагружен сервер, с которого мы запустили весь этот процесс, поэтому мы отвалимся от его консоли. Пугаться не надо… После того, как система поднимется из перезагрузки, снова залогинимся и запустим консоль Server Manager, где через несколько секунд автоматически запустится мастер развертывания ролей RDS и мы сможем убедиться в том, что процесс развертывания успешно прошёл до конца на всех серверах.

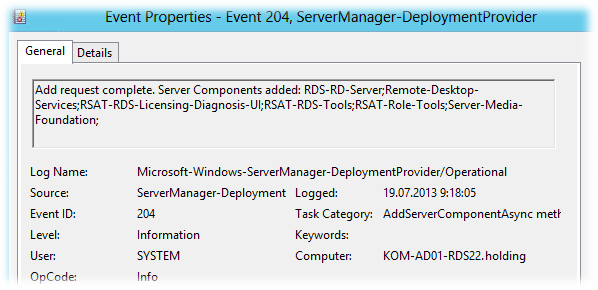

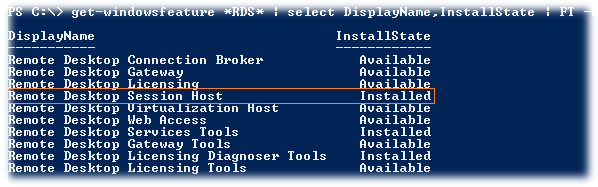

В нашем примере мастер сообщил о том, что на двух серверах из пяти не удалось установить службу RDSH, хотя последующая проверка этих серверов свидетельствовала об обратном. В системном журнале Applications and Services Logs > Microsoft > Windows > ServerManager-DeploymentProvider > Operational было зарегистрировано событие говорящее об успешной установке компонент…

Ну и соответственно PS-запрос состояния компонент RDS показывал что роль RDSH установлена..

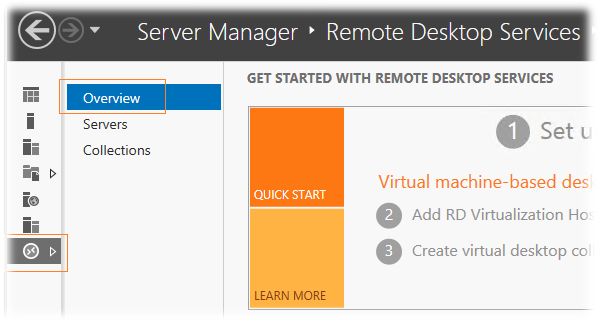

В любом случае если Server Manager упорно будет говорить вам о том, что роль RD Session Host не установлена на каких-то серверах, то для того чтобы заставить её "прокашляться", можно повторить процедуру установки через мастер добавления ролей RDS на вкладке управления службами Remote Desktop Services > Overview

Создаём высоко-доступный RD Connection Broker

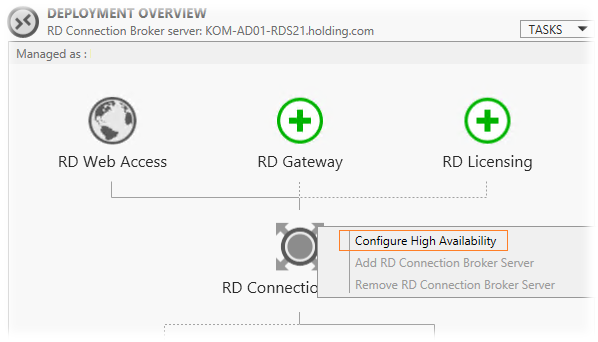

После окончания процесса установки ролей в консоли Server Manager и перейдём на вкладку управления службами Remote Desktop Services > Overview, чтобы приступить к созданию отказоустойчивой конфигурации RD Connection Broker.

На схеме инфраструктуры RDS выберем изображение роли RD Connection Broker и правой кнопкой мыши вызовем меню, в котором выберем пункт Configure High Availability.

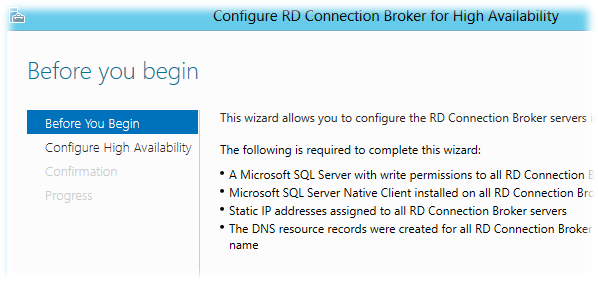

Запустится мастер создания высоко-доступного экземпляра RDCB, где нас предупредят о необходимых условиях, которые мы уже предварительно выполнили, за исключением последнего пункта, который предполагает создание в DNS A-записей c одинаковым FQDN именем RDCB и IP адресами всех серверов (для работы механизма Round Robin). Откажемся от концепции использования DNS Round Robin для получения клиентами имени точки подключения к ферме RDCB. Вместо этого мы будем использовать имя созданного ранее NLB кластера.

Запустится мастер создания высоко-доступного экземпляра RDCB, где нас предупредят о необходимых условиях, которые мы уже предварительно выполнили, за исключением последнего пункта, который предполагает создание в DNS A-записей c одинаковым FQDN именем RDCB и IP адресами всех серверов (для работы механизма Round Robin). Откажемся от концепции использования DNS Round Robin для получения клиентами имени точки подключения к ферме RDCB. Вместо этого мы будем использовать имя созданного ранее NLB кластера.

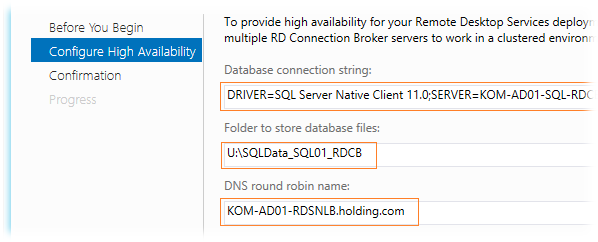

На следующем шаге мастера Configure High Availability заполняем значения трёх полей:

Database connection string – строка подключения к БД SQL Server. Значение должно иметь вид: DRIVER=SQL Server Native Client 11.0 (10.50 для SQL Server 2008 R2);SERVER=<FQDN-Имя или SQL-Alias сервера SQL Server>;Trusted_Connection=Yes;APP=Remote Desktop Services Connection Broker;DATABASE=<Имя БД>

В нашем случае это значение будет иметь следующий вид:

DRIVER=SQL Server Native Client 11.0;SERVER=KOM-AD01-SQL-RDCB.holding.com;Trusted_Connection=Yes;APP=Remote Desktop Services Connection Broker;DATABASE=RDS_ConnectionBroker

Folder to store database files - путь ранее подготовленного каталога U:\SQLData_SQL01_RDCB на кластерном диске SQL сервера. В этом каталоге будут размещены файл данных и лога транзакций SQL Server при создании БД RDCB.

DNS round robin name – имя точки подключения клиентов. Как я уже сказал, здесь предполагается ввод значения FQDN-имени созданного в DNS с несколькими A-записями. В нашем примере, в качестве такого имени, мы будем использовать имя созданного ранее NLB кластера – KOM-AD01-RDSNLB.holding.com

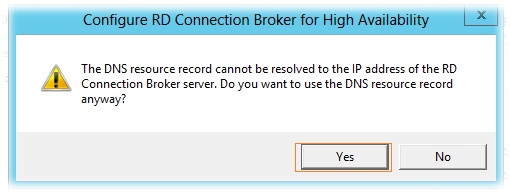

Далее мы получим предупреждение о том, что указанное нами имя DNS RR имеет отличный IP адрес от того, для которого выполняется установка HA RDCB. Мы идём на этот шаг намеренно и поэтому соглашаемся…

Далее мы получим предупреждение о том, что указанное нами имя DNS RR имеет отличный IP адрес от того, для которого выполняется установка HA RDCB. Мы идём на этот шаг намеренно и поэтому соглашаемся…

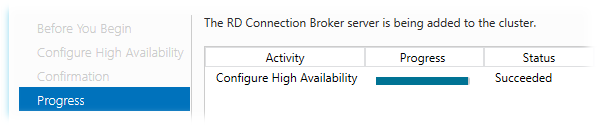

Дожидаемся успешного окончания процесса конфигурирования высокой доступности.

В ходе этого процесса на SQL-сервере будет создана БД высоко-доступного экземпляра RDCB.

***

Переключимся на наш SQL Server с только что созданной БД и выполним пару настроек…

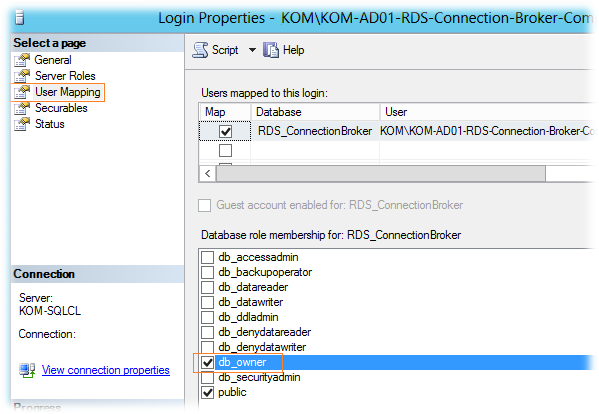

В обязательном порядке для SQL-логина, который мы создавали на подготовительном этапе (KOM-AD01-RDS-Connection-Broker-Computers), нужно дать роль db_owner для созданной базы RDS_ConnectionBroker

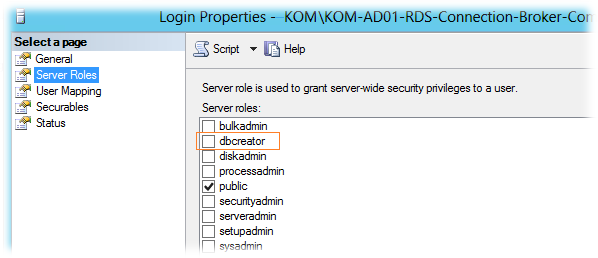

Помимо этого, для данного SQL-логина можно отключить добавленную ранее серверную роль dbcreator, так как БД уже создана и больше данная привилегия этому SQL-логину не потребуется.

Если резервное копирование баз данных SQL Server выполняется такими инструментами как например SC 2012 DPM, то при желании мы можем поменять модель восстановления созданной БД (Recovery Model) c Full на Simple.

***

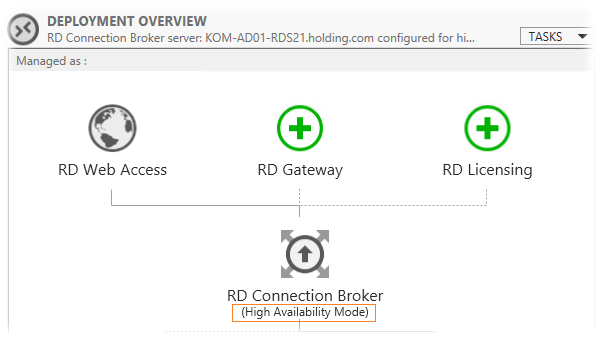

Вернёмся на наш сервер KOM-AD01-RDS21 и обратим внимание на то, что в консоли Server Manager в схеме инфраструктуры RDS статус роли RDCB поменялся на High Availability Mode

Теперь для того чтобы задуманная нами связка NLB + RDCB работала так как нужно, нам необходимо до-установить роль RD Connection Broker на оставшиеся четыре сервера.

Добавляем сервера в высоко-доступный RD Connection Broker

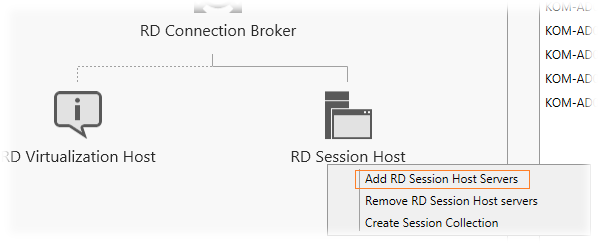

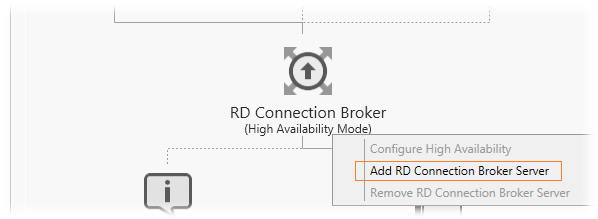

Добавление серверов к высоко-доступной конфигурации RDCB делается через то же самое контекстное меню в схеме развертывания RDS на странице Overview.

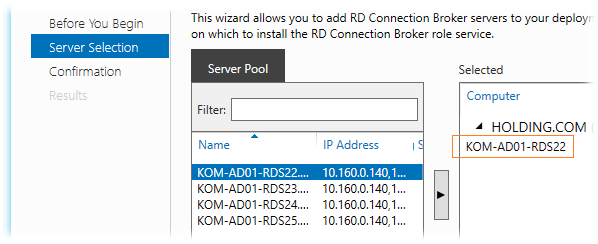

В открывшемся мастере добавляем следующий сервер (мастер также не даст добавить более одного сервера)

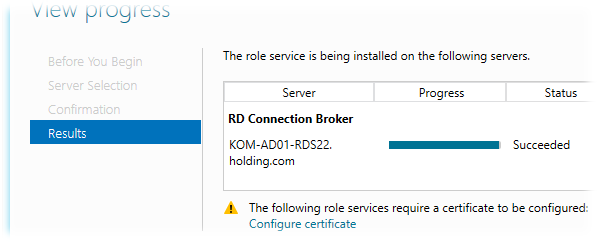

После успешного добавления роли на выбранный сервер и подключение этого сервера к БД HA RDCB мы получим предупреждение о необходимости настройки сертификатов, которое пока можем проигнорировать, так как займёмся сертификатами позже.

Аналогичным образом мы по одному серверу должны добавить роль HA RDCB на все оставшиеся сервера, те. KOM-AD01-RDS23, KOM-AD01-RDS24 и KOM-AD01-RDS25.

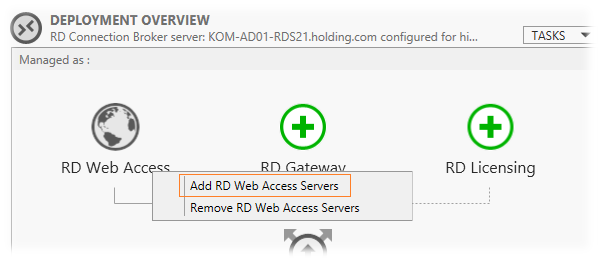

Добавляем на сервера роль RD Web Access

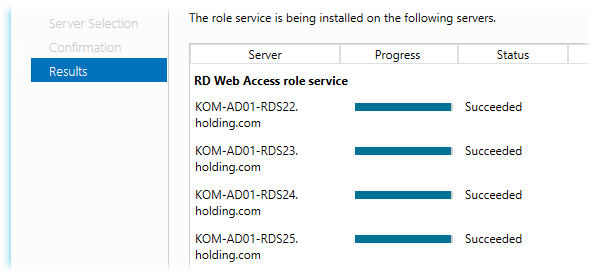

Так как мы хотим иметь отказоустойчивую конфигурацию роли RD Web Access, нам нужно до-установить эту роль на оставшиеся четыре сервера (на KOM-AD01-RDS21 эта роль уже установлена). Делаем это в уже знакомом нам месте через мастер добавления ролей

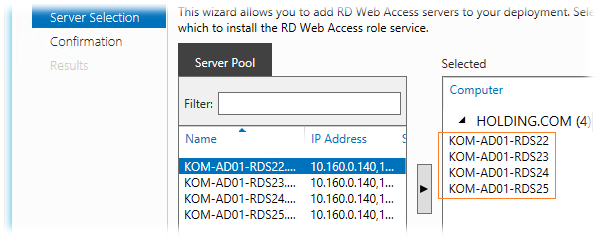

Здесь уже мы сможем выбрать сразу все серверы и выполнить установку роли RDWA оптом…

Здесь уже мы сможем выбрать сразу все серверы и выполнить установку роли RDWA оптом…

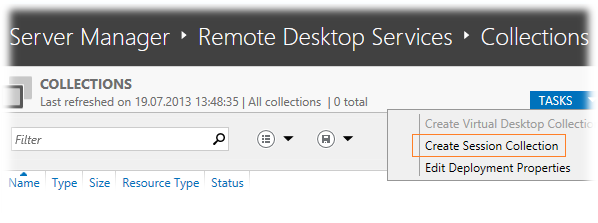

Создаём коллекцию сеансов – Session Collection

Все наши сервера с ролью RD Session Host мы должны объединить в логическую единицу – коллекцию сеансов (Session Collection). Делаем это в оснастке Server Manager на вкладке Remote Desktop Services > Collections выбрав задачу Create Session Collection в таблице перечисления коллекций.

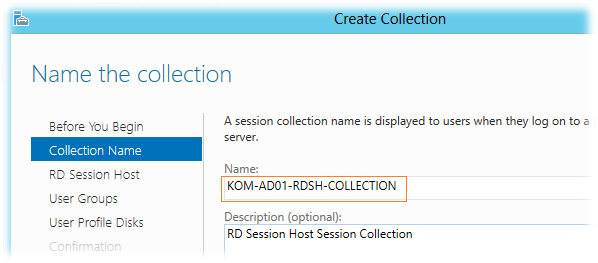

В открывшемся мастере создания коллекции зададим имя коллекции и при желании описание

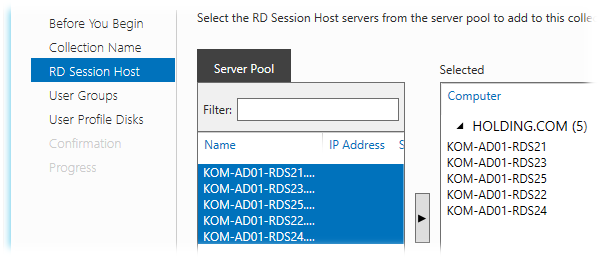

Затем выбираем все сервера, которые хотим сделать членами коллекции…

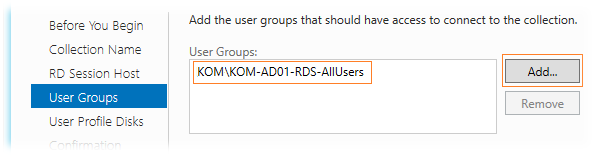

Далее мы должны определить доменную группу безопасности которой будет разрешено подключаться к коллекции сеансов. Убираем выбранную по умолчанию группу доступа Domain Users и добавляем специально созданную группу доступа, в нашем случае KOM-AD01-RDS-AllUsers, ограничив тем самым круг пользователей которые смогут подключаться к серверам коллекции.

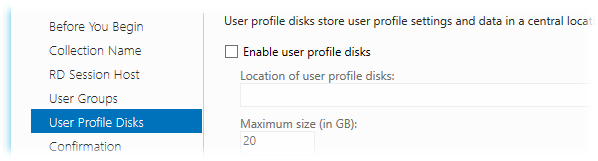

На следующем шаге определяемся с тем, хотим ли мы использовать новую технологию Windows Server 2012 – User profile disks (UPD), которая, как я понял, предлагается в качестве альтернативы механизму перемещаемых профилей - Roaming User Profiles. Новая технология подразумевает централизованное хранение файлов пользователя в отдельных VHD дисках, которые располагаются где-то на выделенном файловом ресурсе. В силу того, что на данный момент нет уверенности в стабильности работы данного механизма из-за полученной информации в обсуждении Windows Server 2012 RDS - [User Profile Disk] VS [Roaming Profiles + Folder Redirection] я решил пока не использовать данный функционал и поэтому он не будет рассмотрен в данной заметке.

А пока не будут разрешены имеющиеся на данный момент проблемы с UPD будем использовать связку технологий Roaming User Profiles и Folder Redirection, настройка которых рассматривалась ранее в заметке Remote Desktop Services – Используем перенаправление профилей пользователей и перемещаемые папки

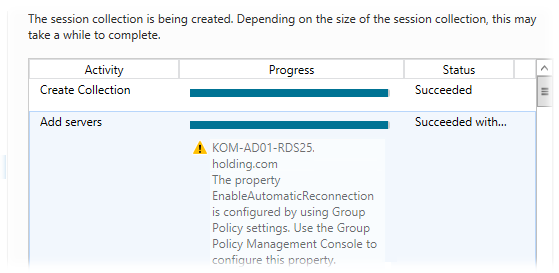

В результате работы мастера все наши сервера успешно добавляются в коллекцию с предупреждениями о том, что желательна настройка групповых политик для задания параметров RDP на этих серверах…

Настраиваем цифровые сертификаты

При попытке подключения к ферме RD Connection Broker по FQDN-имени кластера NLB клиенты могут получать предупреждение безопасности, говорящее о том, что нет доверия сертификату того сервера сеансов, на который он был перенаправлен. Если открыть свойства этого сертификата, мы увидим, что сертификат создаваемый на сервере RDSH по умолчанию является самоподписанным. Чтобы избежать таких предупреждений нам нужно создать для развёртывания RDS сертификат подписанный доверенным Центром сертификации (ЦС), например локальным изолированным или доменным ЦС. Этот сертификат после создания мы развернём на всех серверах фермы.

При создании запроса на сертификат нужно использовать как минимум 2 политики применения:

Client Authentication (1.3.6.1.5.5.7.3.2)

Server Authentication (1.3.6.1.5.5.7.3.1)

Хотя в нашей ситуации альтернативные имена в сертификате Subject Alternative Name (SAN) иметь вовсе необязательно, я всё-таки рассмотрю вариант создания именно такого сертификата, то есть чтобы помимо имени NLB кластера в сертификате содержались имена отдельных серверов.

Для того чтобы наш локальный ЦС мог корректно обрабатывать запросы сертификатов с SAN он должен быть настроен для этого. О том как это сделать можно прочитать в заметке Remote Desktop Services – Строим отказоустойчивую ферму RD Connection Broker

Подготовим файл параметров для создания запроса на получение нужного нам сертификата. Это обычный текстовый файл, назовём его например RequestPolicy.inf

Содержимое этого файла в нашем примере выглядит так:

[Version] Signature="$Windows NT$" [NewRequest] Subject = "CN=KOM-AD01-RDSNLB.holding.com" ; Exportable = TRUE; Private key is exportable KeyLength = 2048 KeySpec = 1; Key Exchange – Required for encryption KeyUsage = 0xA0; Digital Signature, Key Encipherment MachineKeySet = TRUE ProviderName = "Microsoft RSA SChannel Cryptographic Provider" RequestType = PKCS10 [EnhancedKeyUsageExtension] OID=1.3.6.1.5.5.7.3.1 ; Server Authentication OID=1.3.6.1.5.5.7.3.2 ; Client Authentication [RequestAttributes] SAN = "dns=KOM-AD01-RDSNLB.holding.com&" _continue_ = "dns=KOM-AD01-RDS21.holding.com&" _continue_ = "dns=KOM-AD01-RDS22.holding.com&" _continue_ = "dns=KOM-AD01-RDS23.holding.com&" _continue_ = "dns=KOM-AD01-RDS24.holding.com&" _continue_ = "dns=KOM-AD01-RDS25.holding.com&" _continue_ = "dns=KOM-AD01-RDSNLB&" _continue_ = "dns=KOM-AD01-RDS21&" _continue_ = "dns=KOM-AD01-RDS22&" _continue_ = "dns=KOM-AD01-RDS23&" _continue_ = "dns=KOM-AD01-RDS24&" _continue_ = "dns=KOM-AD01-RDS25&"

С помощью встроенной в ОС утилиты CertReq.exe создадим файл запроса на основе файла параметров:

cd /d C:\Temp

CertReq –New RequestPolicy.inf RequestFile.req

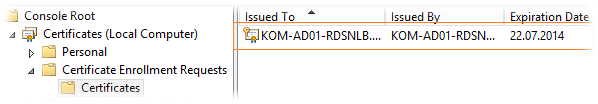

Выполнять эту команду надо локально на сервере RDS. В нашем случае команда выполняется на сервере KOM-AD01-RDS21. После выполнения команды откроем консоль управления локальными сертификатами (mmc.exe > Add/Remove snap-in > Certificates > Add > Computer account) для хранилища Local Computer и убедимся в появлении ожидающего запроса в разделе Certificate Enrollment Request

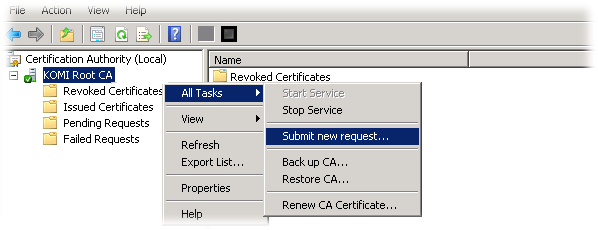

Полученный файл запроса RequestFile.req добавляем в локальный центр сертификации через консоль управления Certification Authority (certsrv.msc) (All Tasks > Submit new request)

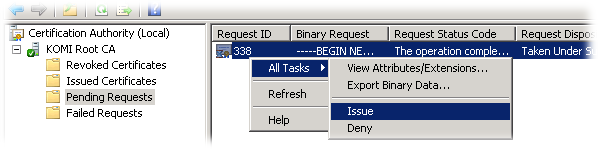

Затем в этой же консоли в разделе Pending Requests проверяем наш добавленный запрос и разрешаем выдачу сертификата по нему (Выбираем запрос > All Tasks > Issue )

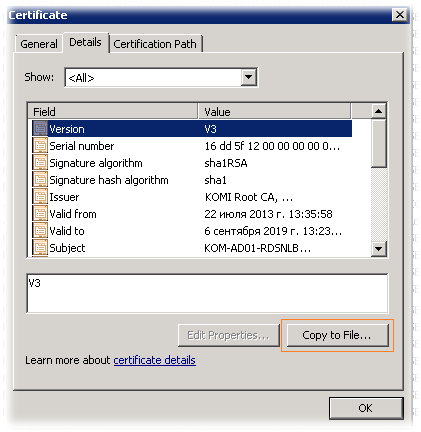

Переходим в раздел выданных сертификатов - Issued Certificates, находим сертификат, открываем его свойства и на закладке Details вызываем мастер экспорта сертификата (Copy to File)

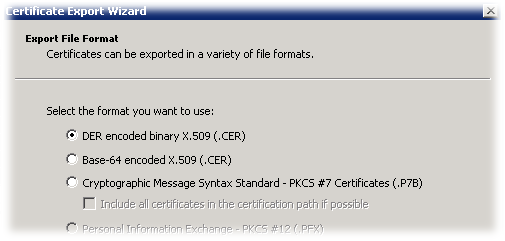

В открывшемся мастере выбираем формат экспорта DER X.509 и сохраняем файл например с именем NLBCert.cer

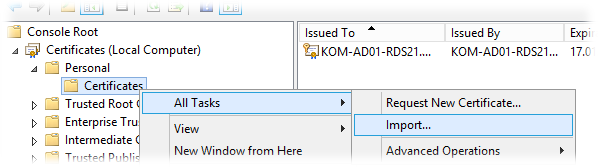

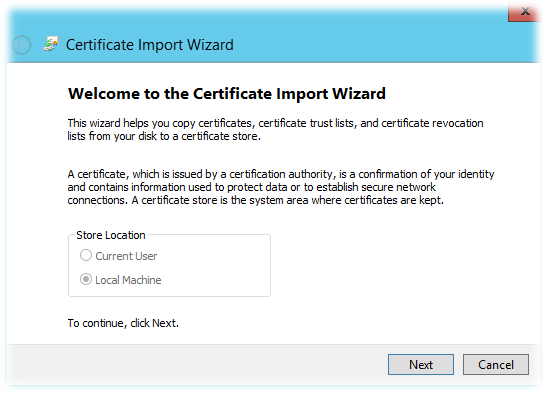

Скопируем полученный файл NLBCert.cer на сервер RDS, где мы создавали запрос на сертификат (KOM-AD01-RDS21) и вернёмся в консоль управления локальными сертификатами этого сервера. Выберем хранилище Personal > Certificates и вызовем мастер импорта сертификатов (All Tasks > Import)

В мастере импорта автоматически будет выбрано хранилище Local Machine

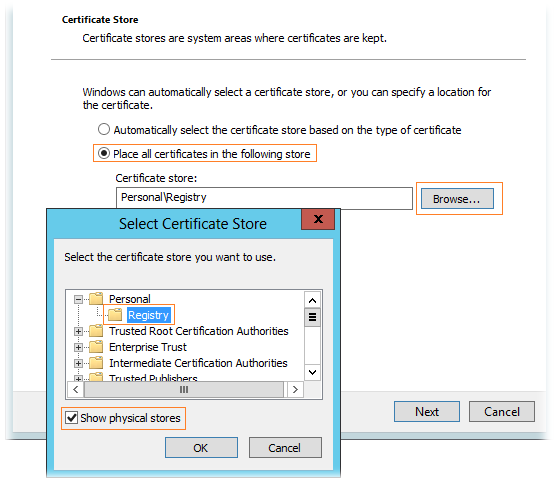

Далее выберем импортируемый файл сертификата NLBCert.cer и укажем раздел хранилища Personal\Registry. Чтобы этот раздел был доступен для выбора, нужно включить опцию Show physical stores.

После того как импорт сертификата выполнен, убеждаемся что он появился в соответствующем хранилище и с ним связан его закрытый ключ (присутствует значок ключика на иконке). При этом в разделе Certificate Enrollment Request информация о запросе должна исчезнуть.

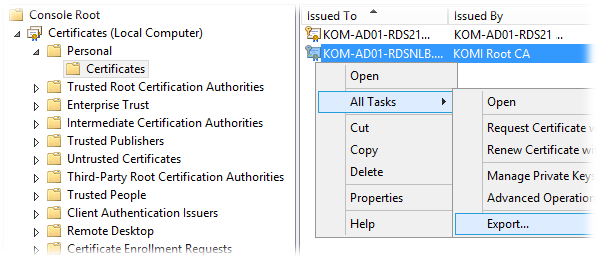

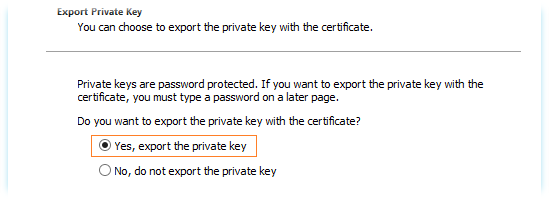

Далее выбираем установленный сертификат и вызываем мастер экспорта (All Task > Export). В мастере экспорта выбираем опцию экспорта закрытого ключа при экспорте сертификата – Yes, export the private key

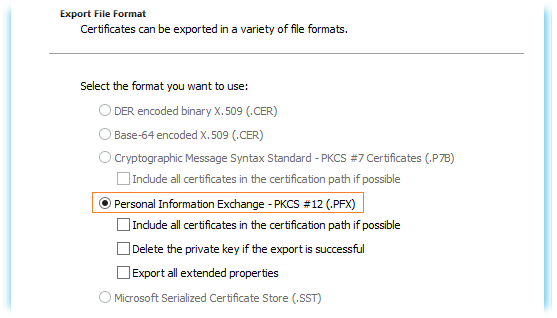

В качестве формата экспорта используем единственно возможный и нужный нам формат .PFX

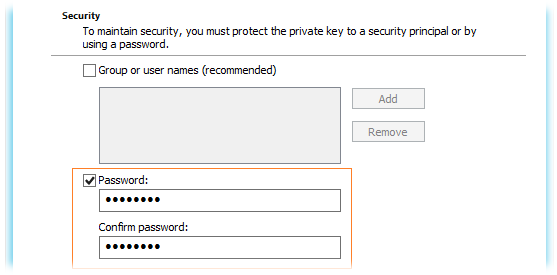

Далее задаем пароль (он потребуется нам в дальнейшем для назначения этого сертификата в развёртывании RDS)

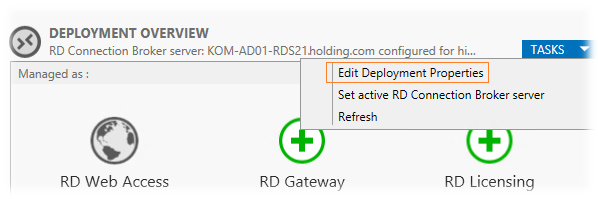

После того как сертификат экспортирован, переходим в консоль Server Manager\Remote Desktop Services\Overview и на схеме развёртывания в списке задач выбираем пункт редактирования развёртывания (TASKS > Edit Deployment Properties)

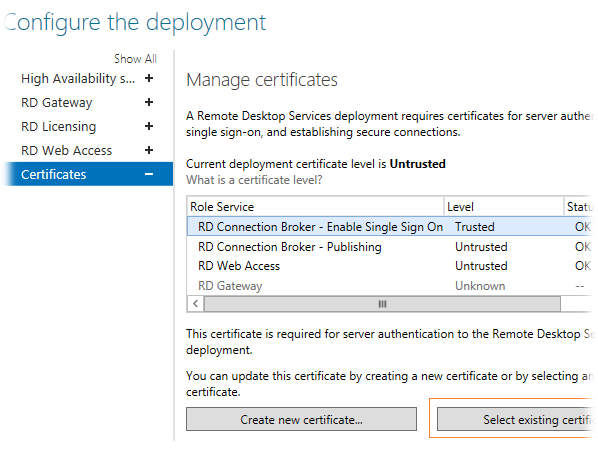

На вкладке Certificates используем кнопку Select existing cerificates для того чтобы назначить сделанный нами сертификат для той или иной роли RDS…

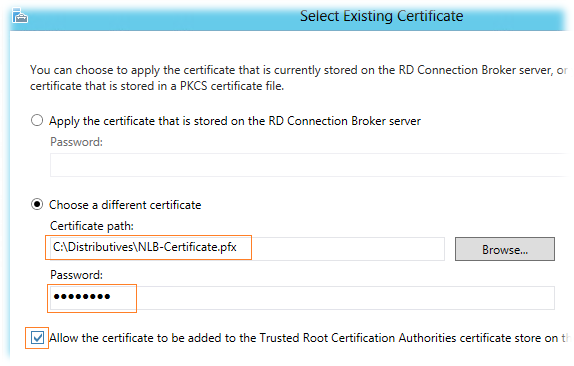

В окне выбора сертификата определяем, что мы хотим использовать файл PFX полученный нами ранее и задаём пароль с которым этот сертификат был экспортирован. Хотя опция Allow the certificate to be added to the Trusted Root CA нам по сути не нужна, так как созданный нами сертификат сделан в ЦС, которому предположительно все наши сервера уже доверяют, её всё таки придётся отметить, так как если она не отмечена, кнопка OK недоступна…

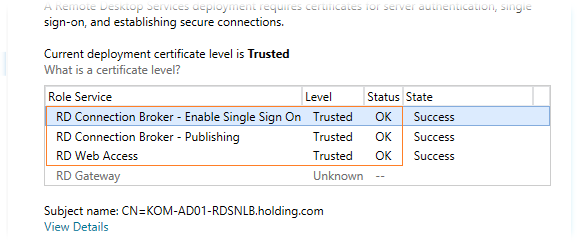

После закрытия этого окна по ОК, мы увидим что в таблице статус сертификата изменился на Ready to apply..Нажмём кнопку Apply и через несколько секунд наш сертификат будет назначен роли соответствующей RDS. Описанным методом мы выполним привязку сертификатов ко всем развёрнутым у нас ролям и в конечном итоге получим примерно следующий вид:

Назначенные нами сертификаты будут автоматически установлены на все сервера, которые участвуют в нашем RDS развёртывании.

Настраиваем веб-узлы RD Web Access

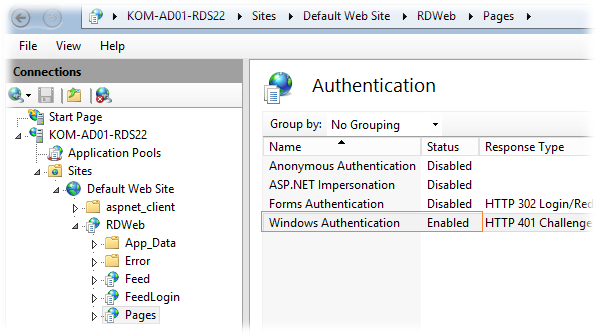

По умолчанию при обращении в стартовой веб-странице RDWA от пользователя в явном виде требуется ввод учетной записи и пароля. Если мы используем RDWA для доменных пользователей внутри локальной сети, то для удобства нам нужно будет задействовать механизм прозрачного входа Single sign-on (SSO) при обращении к веб-узлу RDWA. Для этого на каждом сервере с установленной ролью RDWA в оснастке IIS Manager откроем свойства веб-приложения RDWeb > Pages выберем в разделе настроек пункт Authentication…выключим анонимную аутентификацию (Anonymous Authentication), аутентификацию на основе формы (Forms Authentication) и включим Windows Authentication:

***

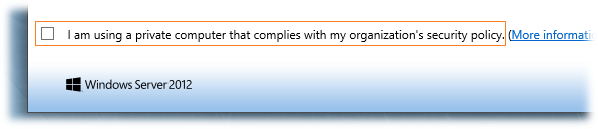

После входа на веб-страницу RDWA можно обнаружить уже знакомый нам по предыдущей версии опцию I am using a private computer that complies with my organization's security policy (в русском варианте - Я использую личный компьютер, соответствующий политике безопасности моей организации).

Ранее, в заметке RDS Web Access – Опция "Я использую личный компьютер…", я писал о том, как выставить эту опцию во включенное состояние по умолчанию, чтобы избежать повторного запроса аутентификации при подключении к опубликованным приложениям RemoteApp в Windows Server 2008 R2. Это рецепт работает и для Windows Server 2012.

***

Верхняя часть страниц RDWA по умолчанию оформлена в виде заголовочной надписи Work Resources и изображения размером 48*48 пикселей.

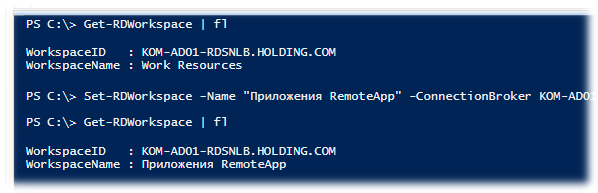

Для того чтобы заменить заголовочную надпись можно использовать командлет PowerShell (один раз для всей коллекции серверов):

Set-RDWorkspace -Name "Приложения RemoteApp" -ConnectionBroker KOM-AD01-RDS21.holding.com

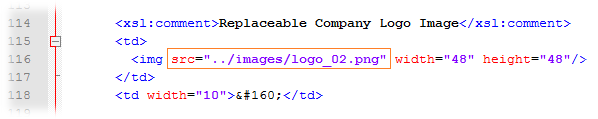

Для того чтобы заменить имеющееся изображение на другое, например с корпоративной символикой, можно внести корректировки в файл %windir%\Web\RDWeb\Pages\Site.xsl – найти секцию с комментарием "Replaceable Company Logo Image"…

… и заменить ссылку на файл изображения, указав собственный файл размещённый в соответствующем подкаталоге %windir%\Web\RDWeb\Pages\images

В результате мы получим примерно следующий вид верхней части страниц RDWA:

Настраиваем Roaming User Profiles и Folder Redirection

Так как пользователи нашей фермы RDS от сеанса к сеансу могут попадать на разные сервера, нам необходимо обеспечить идентичность пользовательской среды на всех этих серверах. Для этого мы будем использовать механизмы перемещаемых профилей (Roaming User Profiles ) и перенаправления папок (Folder Redirection). Для настройки этих механизмов настраиваем групповую политику применяемую к серверам нашей фермы RDS. Здесь мы не будем рассматривать эту процедуру, так как она уже была ранее описана мной в заметке Remote Desktop Services – Используем перенаправление профилей пользователей и перемещаемые папки

Публикуем приложения RemoteApp

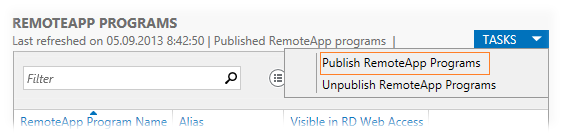

Чтобы опубликовать в ферме RDS приложения RemoteApp переходим в консоль Server Manager в раздел Remote Desktop Services > Collections > выбираем нашу коллекцию KOM-AD01-RDSH-COLL и публикуем необходимые приложения в окне REMOTEAPP PROGRAMS. В меню задач выбираем пункт публикации TASKS > Publish RemoteApp Programs

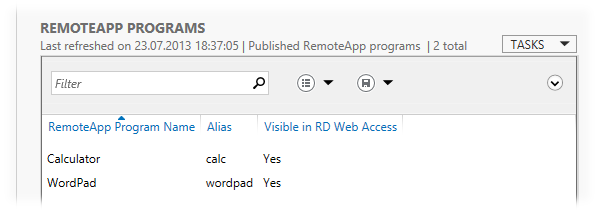

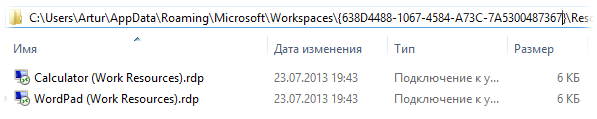

Для примера опубликуем два простых приложения Calculator и WordPad

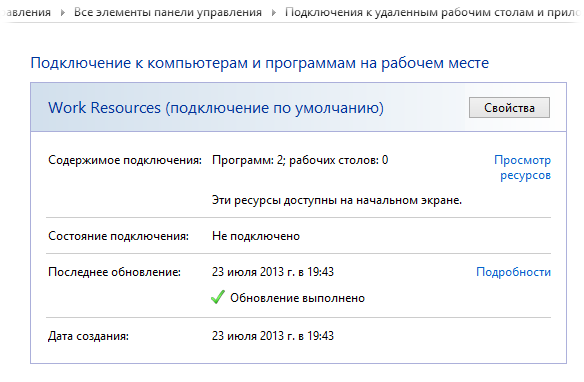

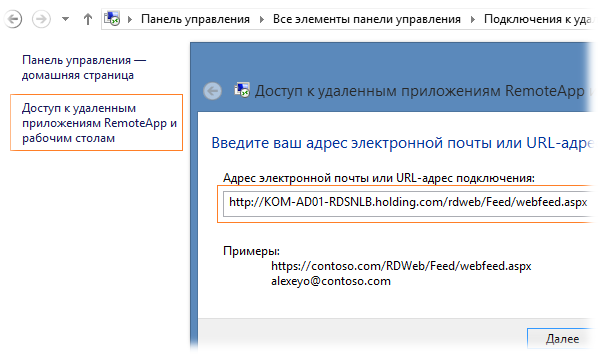

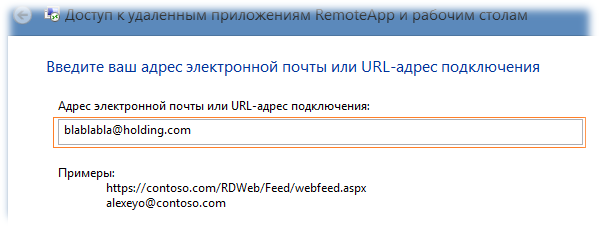

Опубликованные приложения доступны клиентам нашей фермы RDS двумя основными способами – через веб-интерфейс RD Web Access и через непосредственную доставку ярлыков запуска на клиентские компьютеры. С первым способом, полагаю, всё итак понятно, рассмотрим второй. Для того чтобы ярлыки опубликованных приложений RemoteApp стали доступны на клиенте с Windows 7/8, нужно выполнить подписку на узел RDWA в Панели управления (апплет Подключения к удаленным рабочим столам и приложениям RemoteApp). Щелкнув по ссылке Доступ к удалённым приложениям RemoteApp и рабочим столам мы вызовем мастер подключения, где в адресной строке укажем URL RDWA в формате http://KOM-AD01-RDSNLB.holding.com/RDWeb/Feed/WebFeed.aspx

В примерах описанных в окне подключения можно заметить вариант с указанием адреса, похожего на адрес электронной почты - alexeyo@contoso.com. На самом деле такой метод указания адреса не столько имеет отношение к электронной почте, сколько относится к методу автоматического обнаружения сервера публикации RemoteApp с помощью специальных записей в зоне прямого просмотра DNS. То есть мастеру подключения важно лишь то, что указано после символа @ – имя зоны DNS. До символа @ можно написать любую ерунду. Например, в нашем примере в DNS используется зона holding.com и в качестве адреса мы можем указать например blablabla@holding.com

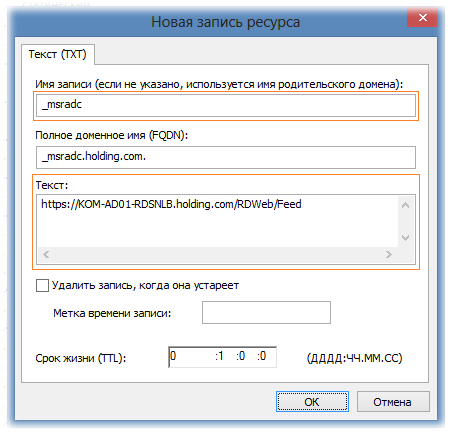

В зоне DNS соответственно при использовании такого метода должна быть создана специальная запись формата TXT c именем _msradc и текстовым значением в формате https://rds.domain.com/rdweb/feed

Соответственно в нашем примере запись будет иметь следующий вид:

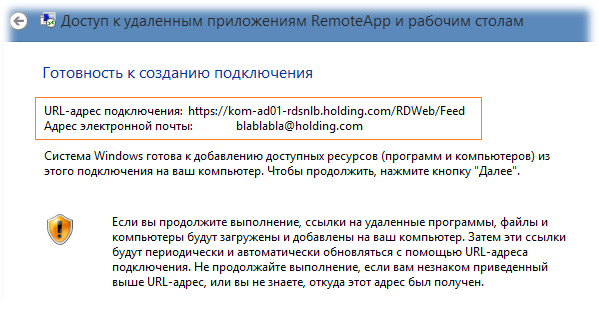

После того как запись создана, проверим то, что DNS сервер возвращает нам значение этой записи с помощью утилиты nslookup в режиме set querytype=TXT и если всё в порядке, то теперь в качестве адреса подключения можем указать соответствующее значение

При этом из DNS будет возвращён URL-адрес подключения…

После этого может последовать запрос на ввод учетных данных пользователя, чтобы узел RDWA выполнил идентификацию пользователя и определил какие ярлыки на приложения RemoteApp можно показать пользователю согласно доменных групп безопасности, включенных в правилах публикации. В нашем примере будет отображена информация об успешном подключении и количестве доступных пользователю программ

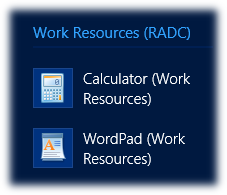

При этом в меню “Пуск” для Windows 7 и в стартовом экране для Windows 8 в отдельной группе появятся ярлыки на запуск приложений RemoteApp

При этом в меню “Пуск” для Windows 7 и в стартовом экране для Windows 8 в отдельной группе появятся ярлыки на запуск приложений RemoteApp

Если вам потребуется каким-то альтернативным способом распространять ярлыки на приложения RemoteApp, то их можно будет найти на клиентской машине подключённой вышеописанным способом к точке публикации RDWA в каталоге

%APPDATA%\Microsoft\Workspaces{GUID}\Resource

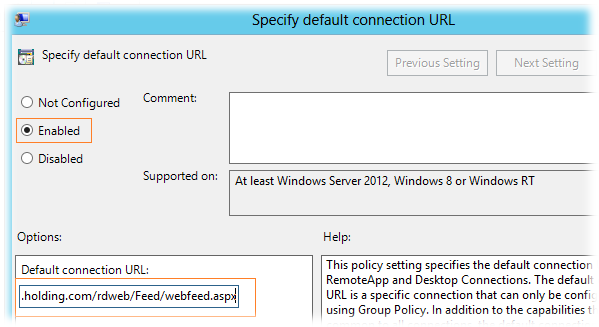

Нововведением Windows 8 стал ещё один способ подключения клиентов к точке публикации – с помощью групповых политик (GPO). За это отвечает параметр

Specify default connection URL в разделе User Configuration/Policies/Administrative Templates/Windows Components/Remote Desktop Services/RemoteApp and Desktop Connections. Для настройки клиентов нужно включить этот параметр и указать значение URL-адреса подключения в формате:

https://KOM-AD01-RDSNLB.holding.com/rdweb/Feed/webfeed.aspx

Как я уже сказал, этот параметр поможет нам настроить только клиентов Windows 8, но если у вас есть сильное желание раздать через GPO настройку и для клиентов Windows 7 – читайте статью Concurrency Blog - How to deliver RemoteApps from Windows Server 2012 RDS. Метод заключается в применении на клиентских машинах PowerShell скрипта Configure RemoteApp and Desktop Connection on Windows 7 Clients с передачей ему в виде параметра файла настроек в следующем формате:

<?xml version="1.0" encoding="utf-8" standalone="yes"?> <workspace name="Enterprise Remote Access" xmlns="http://schemas.microsoft.com/ts/2008/09/tswcx" xmlns:xs="http://www.w3.org/2001/XMLSchema"> <defaultFeed url="https://KOM-AD01-RDSNLB.holding.com/rdweb/Feed/webfeed.aspx" /> </workspace>

Устанавливаем языковой пакет

Так как в нашем примере на серверах фермы RDS используется англоязычная система, нам потребуется установка языкового пакета для локализации интерфейса пользователя. Чтобы получить файлы русского языкового пакета распаковываем образ содержащий все языковые пакеты для Windows Server 2012 RTM SW_DVD5_NTRL_Win_Svr_Language_Pack_2012_64Bit_MultiLang_FPP_VL_OEM_X18-27741.ISO

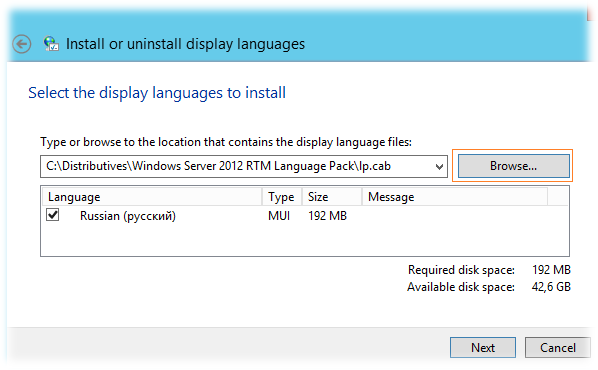

Извлекаем файл langpacks\ru-ru\lp.cab из состава образа и вызываем на сервере RDS мастер установки языковых пакетов командой lpksetup

Помимо этого установку языкового пакета можно выполнить командой:

Dism /online /Add-Package /PackagePath:"C:\Distributives\WS2012RTMLanguagePack\lp.cab"

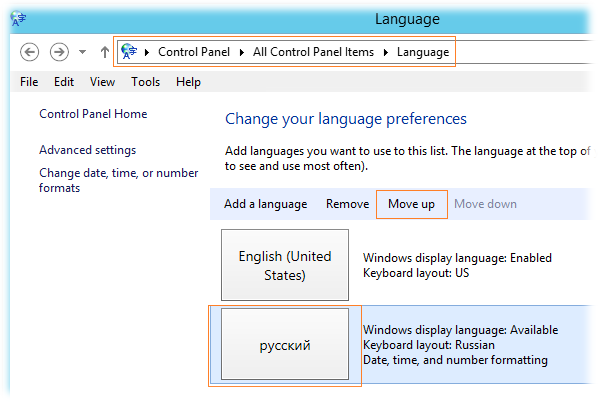

Практика показывает, что после выполнения этой команды, для того чтобы в панели управления появилась информация о том, что языковой пакет действительно установлен, – необходима перезагрузка системы. После перезагрузки сервера RDS переходим в панель управления в раздел Language и выделив русский язык кнопкой Move Up поднимаем его на первую позицию, сделав его таким образом приоритетным языком интерфейса.

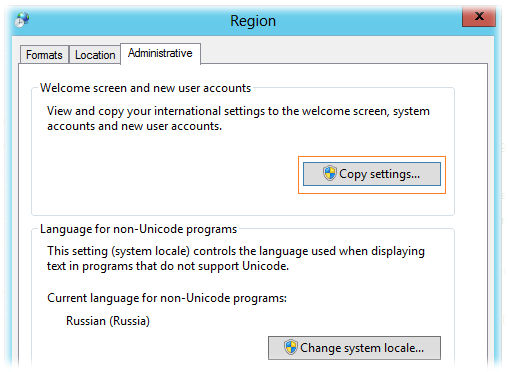

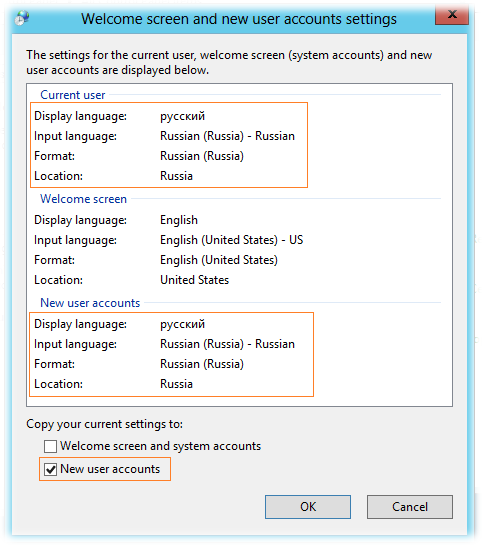

Далее открываем апплет панели управления Control Panel > Region (intl.cpl) , проверяем и при необходимости настраиваем параметры на родной язык на закладках Formats и Locations , а затем на закладке Administrative нажимаем Copy settings, чтобы скопировать языковые предпочтения текущего пользователя для всех пользователей которые будут первый раз входить в эту систему.

Убедимся что у текущего пользователя установлены такие настройки, которые мы хотим иметь у всех пользователей сервера RDS и включим галочку New user accounts

Не рекомендую использовать опцию копирования русских настроек в системный профиль (галка Welcome screen and system accounts), так как это в перспективе может привести к невменяемой работе некоторых “буржуйских” программ, проблемы в которых возникают чаще всего из-за знака разделителя целой и дробной части.

Настраиваем перенаправление печати

Для того чтобы пользователи служб удалённых рабочих столов смогли выполнять печать на перенаправленные с их клиентских мест устройств печати, выполним ряд нехитрых манипуляций.

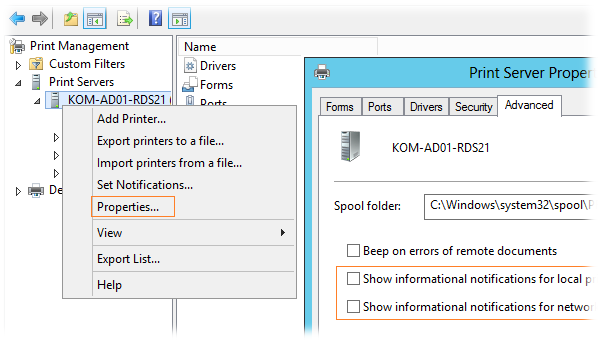

Установим на сервера RDS консоль управления службой печати – Print Management, например с помощью PowerShell:

Add-WindowsFeature RSAT-Print-Services

Если есть сильное желание управлять службой печати на всех серверах например с рабочей станции Администратора, то для того, чтобы можно было удалённо подключаться к службе печати, на серверах необходимо включить параметр групповой политики Allow Print Spooler to accept client connections в разделе Computer Configuration\Policies\Administrative Templates\Printers. После применения политики на серверах нужно перезапустить службу очереди печати - Print Spooler.

На мой взгляд использовать локально установленную на серверах консоль – более предпочтительно.

После установки открываем консоль, добавляем в неё наши сервера, и в свойствах сервера печати для каждого сервера выполняем необходимые изменения настроек, например на закладке Advanced отключаем включённые по умолчанию оповещения сетевых и локальных принтеров…

К слову об использовании именно локальной консоли…эти две опции недоступны для изменения (попросту не видны) если вы подключаетесь консолью удалённо.

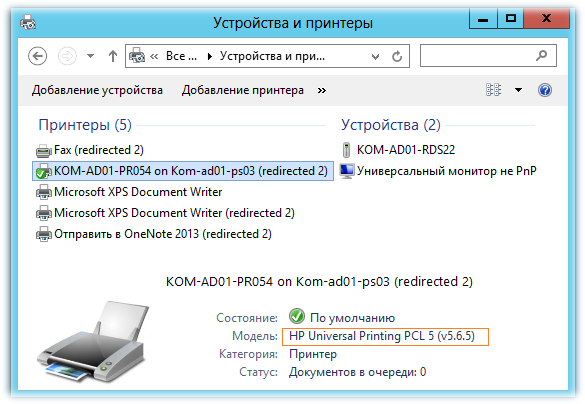

На закладке Drivers добавляем драйвера принтеров, которые используются для печати на клиентских компьютерах. Драйвера принтеров нужно добавлять исходя из принципа разумного минимума. Например вместо того чтобы для принтеров Hewlett-Packard добавлять несколько драйверов для конкретных моделей лучше добавить один универсальный драйвер HP Universal Print Driver (UPD), в случае если принтеры поддерживают работу на данном драйвере. В нашем примере используется текущая версия (на момент написания этой заметки) UPD совместимая с Windows Server 2012 - 5.6.5.15717. Разумеется добавлять драйвера производителей оборудования вообще имеет резон только в том случае если тесты показывают, что принтер не выполняет поставленные задачи печати на драйвере Remote Desktop Easy Print.

В конфигурации по умолчанию для принтеров перенаправляемых с пользовательских компьютеров система будет использовать драйвер Remote Desktop Easy Print. Если мы загружаем на сервера RDS драйвера производителей принтеров, как например тот же HP UPD, то возможно нам стоит переопределить такое поведение, то есть, чтобы приоритетным для использования считался драйвер вендора железки, а уж если его не удалось найти – использовать RD Easy Print. Задаётся это параметром групповой политики Use Remote Desktop Easy Print printer driver first = Disabled в разделе Computer Configuration\Policies\Administrative Templates\Windows Components\Remote Desktop Services\Remote Desktop Session Host\Printer Redirection

После применения GPO в пользовательской терминальной сессии проверяем какой драйвер был назначен для перенаправленного принтера…

На этом, в целом, можно считать, что мы выполнили основные этапы создания и настройки отказоустойчивой фермы RD Connection Broker на базе Windows Server 2012. В отдельной следующей заметке мы рассмотрим пример настройки пользовательского интерфейса на сервера RD Session Host.

Полезные ссылки по теме:

Remote Desktop Services Blog - RD Connection Broker High Availability in Windows Server 2012

VirtualizationAdmin.com - Taking a closer look at RD Connection Broker High Availability in Windows Server 2012

TechNet Articles - RD Connection Broker HA – SQL Permissions

Freek Berson Blog - RD Connection Broker HA and the RDP properties on the client

Blog Working Hard In IT - Reflections on Getting Windows Network Load Balancing To Work (Part 1)

Blog Working Hard In IT - Reflections on Getting Windows Network Load Balancing To Work (Part 2)

RSS - Записи

RSS - Записи

Спасибо за статью.

Как раз планировали с 2008 на 2012 переходит RDC.

Спасибо, очень содержательно и понятно.

Жду продолжения.

Шикарно!

Обратная ссылка: High Availability RD Connection Broker на базе Windows Server 2012–выявленная закономерность в конфигурации с более чем 3 серверами | Блог IT-KB /

Спасибо за подробное и доступное описание всего процесса, очень познавательно. Хочу узнать, с доступом к RDWeb с клиентских машин под управлением WinXP SP3 проблем не наблюдается? Чуть ранее подобный вопрос был на technet (http://social.technet.microsoft.com/Forums/ru-RU/b6fc0d24-8f5e-4756-a773-628fb91bf9b8/sso-windows-xp-rdweb-windows-2012), помечен "отвеченным", однако как и задающий вопрос, так и я, столкнулись именно с такой проблемой - с клиентов XP невозможно зайти нормально. Кажется есть возможность поднять RD Gateway и пробовать перенаправить всех корпоративных клиентов через него, но это будет всем костылям костыль. Может быть ситуация Вам знакома или подскажете, куда ещё можно обратить свой взор? Заранее благодарен за любую оказанную помощь, с уважением, Василь.

Сходу не скажу. Попробуем у себя, и если проблема будет воспроизведена - отпишусь.

Посмотрел на тестовом клиенте на Windows XP SP3 с IE8 и всеми установленными обновлениями с WSUS - действительно проблема имеет место быть, но для нас она не очень актуальна, т.к. количество WinXP стремительно приближается к нулю. На WinXP проблема проявляется каким-то плавающим образом (от обновления к обновлению страницы по F5), то есть страница то загружается, то возникает ошибка загрузки "unable to display rd web access". Проблема описана также в этой ветке:

http://social.technet.microsoft.com/Forums/windowsserver/en-US/daffe906-be42-418d-8552-ec679ffba0ca/error-message-on-rd-web-access-for-server-2012

Как я понял, проблема проявляется только на связке Windows XP SP3 + IE8 и связана она может быть с тем, что IE как-то некорректно обрабатывает загружаемые стили XSLT.

Пробовал разные методы:

1) Отключал использование прокси (чтобы браузер обращался к узлу RDWA напрямую)

2) Сбрасывал все настройки безопасности в браузере. Узел RDWA должен входить в зону доверенных узлов и/или в зону локальной интрасети.

Плавающая ошибка не исчезает.

Как вариант можете попробовать поменять тип аутентификации на IIS с Windows Integrated на Form Based. Вдруг поможет. Я не пробовал)

Другой вариант на таких клиентах для доступа к RDWA использовать альтернативный браузер, например Mozilla FireFox, который должен без проблем работать с RDWA из WS2012.

В любом случае можете выйти с проблемой на техподдержку Microsoft и если появиться универсальный метод решения проблемы - не забудьте нам об этом сообщить :)

PS: Рекомендую задуматься о том, как избавиться от клиентов на Windows XP, если вы до сих пор этого не сделали. Ибо в следующем году кончается срок расширенной поддержки этой ОС http://support.microsoft.com/lifecycle/?c2=1173 и все возможные риски связанные с использованием этой ОС лягут на хрупкие плечи администраторов :)

Алексей, а как правильно отфильтровать ПК с Вин8/Вин8.1 что бы им через ГПО подключить ремоут_апп через webfeed.aspx ??

Вижу как минимум два варианта.

1) Создать отдельную групповую политику с настроенным параметром Specify default connection URL в разделе User Configuration/Policies/Administrative Templates/Windows Components/Remote Desktop Services/RemoteApp and Desktop Connections и включить для её применения WMI фильтр, в котором указать только системы Windows 8/8.1

О том как создать подобный фильтр написал здесь: GPO WMI Filters: WMI-фильтр c отбором по версии Windows

2) Не использовать параметр Specify default connection URL а вместо этого использовать ключ реестра настраиваемый этим параметром и раздать его на нужных клиентов с помощью GPP с нацеливаеием (targeting) на системы Windows 8/8.1

Вариант 2 кажется мне более удобным, так как нужный параметр GPP можно добавить в любую уже работающую GPO, да и работать он будет на мой взгляд быстрей, чем отдельная политика с WMI-фильтрацией (как в п.1)

Алексей, насколько я понял для отказоустойчивости роли RD Connection Broker необходим и достаточен SQL сервер, а NLB нужен для балансировки нагрузки RD Web Access? Т.е., если я не планирую использовать Web Access, то с NLB можно не заморачиваться?

Помимо RDWA NLB в моём описании используется ещё и как средство направления клиентов на RDCB взамен DNS Round Robin. Если Вас устраивает механизм DNS Round Robin, то вполне сможете обойтись и без NLB.

Возможно глупый вопрос, публикуемые апликации нужно устанавливать на каждом сервере отдельно? Или это делается централизованно?

Публикация приложений выполняется на RD Collections централизованно. То есть, если в коллекции несколько серверов, то при публикации приложения через любой из этих серверов подразумевается что публикуемое приложение одинаково доступно по одному и тому же пути на каждом сервере коллекции.

Это понятно. Если я хочу опубликовать например outlook, надо установить его на каждом сервере по отдельности, или есть централизованная установка реплицирующаяся на все сервера

Установка на каждый сервер по отдельности. Публикация - один раз на всю коллекцию серверов. Если серверов в коллекции много и установку делать отдельно на каждый руками грустно, то можно использовать разнообразные средства автоматизации, например SCCM.

Thnx! Great manual!

Отличный мануал, все работает))

Маленький вопрос, как оживить кластер если упадет SQL?

Высокодоступный RDCB предполагает высокодоступный SQL Server. В противном случае это будет "колосс на глиняных ногах".

:) индусы до сих пор не используют свою же фабрику...а зачем, ведь упадут продажи sql. И так почти во всем и у всех вендоров.

Помогите, не хочет создаваться база в SQL (2012), на каждом сервере сделал алиасы, по файлу udl, соединяется все отлично, но когда пишешь строчку подключения в брокере, выдает ошибку sql сервер недоступен, уже ради интереса поставил SQL на машину, где установлен рдп брокер, результат один и тот же. Делаю вывод если через клиента проходит подключение к бд, значит сервер виден по сети и доступен, брандмауэр выключил, что еще можно посмотреть, подскажите?

Проверьте установлены ли клиентские компоненты SQL Server. Проверьте телнетом доступность порта 1433. Проверьте все параметры Database connection string и удостоверьтесь в том, что в параметре DRIVER верно указана версия клиентских компонент SQL Server. С остальными вопросами http://forum.it-kb.ru/viewforum.php?f=5

Сделал, все получилось спасибо, но есть одна загвоздка айпи адресс нлб кластера не виден в разных подсетях, то беж работают только те люди, которые находятся в подсети кластера, если пинговать, сервера из разных подсетей они видны, кроме нлб кластера. Подскажите куда копать?, чисто теоретически кластеру нужно добавить шлюз, но где это сделать я так и не нашел. Спасибо

Нужно либо настраивать шлюз на NLB-интерфейсе (думаю трудно не увидеть пример такой настройки в скриншотах заметки), либо включать Forwarding между основным Management-интерфейсом и NLB-интерфейсом. Хотя проблема может быть и в другом, и по сути эта проблема связана скорее с неправильной настройкой конфигурации NLB, чем с темой поста - HA RDCB. Можно попробовать разобрать Вашу проблему на нашем форуме http://forum.it-kb.ru/

Есть ли смысл разносить роли RD Connection Broker, Session Host, Web Access по разным серверам?

А про развертывание "Virtual machine-based desktop deployment" у вас нет статьи?

Этот вопрос не предполагает однозначного ответа. Всё зависит от исходных данных и желаемого результата. С VDI не работал и пока не планирую, поэтому и соответствующих заметок нет.

Алексей, подскажите, как подключить Брокера к sql серверу 2008r2? Создал группу в AD, добавил туда запись компьютера брокера. Создал имя входа - эта группа из АД, дал права sysadmin. При попытке подключения "DRIVER=SQL Server Native Client 10.50;SERVER=sql.local;Trusted_Connection=Yes;APP=Remote Desktop Services Connection Broker;DATABASE=FARMRDCB;" выдает ошибку "База данных недоступна". Надо ли привязывать к имени входа учетные данные, создавать базу руками? Со своими учетными данным подключиться могу

Проблема решилась "DRIVER=SQL Server Native Client 10.0"

А можно ли публиковать на разные серверах фермы разные приложения?

Соответственно чтобы какие-то приложения запускались только с определенного узла*

А как Вы собираетесь брокеру объяснить что какого-то конкретного пользователя нужно отправить на какой-то конкретный узел потому, что он запустил какое-то конкретное приложение? Я такого способа не знаю. Публикуется приложение не на сервер а на пул серверов, то есть на ферму и это подразумевает что это самое приложение должно быть доступно на всех серверах фермы.

Жаль. В Citrix такая возможность реализована простым выбором серверов в ферме, к которым привязано приложение. Спасибо за ответ.

подскажите пожалуйста. После импорта сертификата в локальное хранилище нет возможности экспортировать сертификат с закрытым ключом. в чем может быть проблема?

Здравствуйте. Подскажите пожалуйста, как решается проблема профилей пользователей сеансов удаленных рабочих столов? Так как в ферме много серверов и брокер каждый раз перенаправляет пользователя на разный сервер узлов сеансов, то профили будут тоже все время разные. Получается надо использовать перемещаемые профили из общей папки, которые будут постоянно копироваться на тот сервер, к которому произошло подключение. Или же есть какой-то механизм репликации профилей между серверами в ферме, как например это делается с объектами в каталоге AD?

Спасибо.

Здравствуйте. Если Вы внимательно прочитаете всю заметку, то обнаружите в ней раздел "Настраиваем Roaming User Profiles и Folder Redirection", где есть ссылка на более раннюю заметку о том как настроить механизм перемещаемых профилей и перенаправления папок: https://blog.it-kb.ru/2011/12/23/remote-desktop-services-rds-roaming-user-profiles-and-folder-redirection-gpo-settings/.

Она была написана применительно к Windows Server 2008 R2, но вполне справедлива и для Windows Server 2012 / 2012 R2

Спасибо, Алексей. А слона-то я и не заметил :)

Скажите пожалуйста, для работы данной GPO, нужно ли использовать новую технологию репликации папки Sysvol DFS-R или она будет работать и при старой технологии FRS? Дело в том, что у меня лес создавался изначально на 2003, затем был произведен переход на 2012, уровень леса и домена подняты до 2008R2, но технология репликации осталась старая, меня она вполне устраивает. Но теперь, когда я создал по вашему примеру GPO, то она не применяется корректно на серверах фермы. Все остальные GPO для настройки пользовательских окружений, работают. Ошибок в AD нет.

Ваши проблемы с применением GPO не имеют отношения к теме поста. Для обсуждения подобного рода проблем есть форум.

Не работает Ваша схема, если дело касается NAT. Т.е ,если rdscb nlb будет за натом, работать это не будет!

Добрый день. После установки ярлыков на ПК через "Панель управления\Все элементы панели управления\Подключения к удаленным рабочим столам и приложениям RemoteApp" при каждом запуске такого приложения появляется запрос имени и пароля. Птичка "Сохранить пароль" в этом окне отсутствует. Как сделать сквозную авторизацию без запроса пароля. Все машины в домене.

Спасибо.

Посмотрите эту заметку https://blog.it-kb.ru/2011/12/23/microsoft-terminal-services-rds-windows-single-sign-on-via-credssp/

Большое спасибо. Извините за глупый вопрос.

Заметил такую особенность, после перезагрузки любого из серверов фермы, RDP на нём не работает, пока вручную не перезапустить службу "Служба удаленных рабочих столов", притом, что эта служба стартует автоматом. С чем это может быть связано? В логах нет никаких ошибок.

Добрый день. Заметил некую особенность, периодично в логах появляется сообщение The Remote Desktop Connection Broker server detected that the database is not available and will notify all Remote Desktop Connection Broker plug-ins. И через 30 сек все в порядке, также видно что пользователи в это время отваливаются и не могут подключится(пишет восстанавливается подключение ). 5 серверов в ферме, 32 камня + 32 Гб оперативной памяти. Не могу понять в чем причина!?

Отвечу сам - проблема давно решена, причем проблема в тормознутом сиквеле, пришлось перенести базу на другой сиквел сервер. Теперь все - ОК.

Добрый день, подскажите, плиз, как запретить пользователям подключаться по старинке через RDP на рабочий стол сервера терминалов 2012, где развернуты все роли (вебдоступа, узел сеансов, посредник подключения), но оставить возможность запускать опубликованные приложения со своего рабочего стола ярлычком к настроенному соединению (rdp). Если пользователя убрать из традиционной группы "Пользователи удаленного рабочего стола", то и конкретные опубликованные приложения тоже становятся недоступны. Пробовал баловаться в локальной политике безопасности. Тоже самое: нет разрешения на терминальный доступ - невозможно и приложение запустить, есть - велком на рабочий стол. А народ ушлый про Win+R, mstsc все знают. Плиз, Хелп!

Хорошая статья. Спасибо. Но вот с сертификатами застрял. При добавлении RequestFile.req в ЦС ругается, что "В запросе отсутствует информация о шаблоне сертификата и т.д.".. все делается на 2012 R2 .

все просто в самом инф файле в [RequestAttributes] добавьте строку CertificateTemplate = WebServer

после этого снова выполните запрос. Не забудьте после получения crt завершить запрос на сертификат в IIS рдп сервера. Удачи.

сделал. и словил при коннекте эроры, но они правятся. то есть, для рдп все равно на темплейтссертификата ? думалось , что если настраиваем NBL, то там надо для компутертемплейтса делать...

Необходимо ли заводить отдельный SQL-сервер для базы данных RDCB или можно использовать уже существующий? (или рассмотреть вариант миграции существующего на созданный для нужд RDCB, к примеру)

В отдельном SQL-сервере или даже инстансе никакой необходимости нет. Можно использовать существующий.

Добрый день!

А можно создать несколько коллекций, чтоб брокер сам разбрасывал по разным серверам пользователей в зависимости от их группы? Например, ПерваяКол (сервера rds1, rds2), имеют доступ пользователи из группы grFirst; ВтораяКол (сервера rds3, rds4), имеют доступ пользователи из группы grSecond.

Полагаю, что нельзя. Как в таком случае Вы представляете себе поведение брокера если получится так, что подключаемый пользователь входит и в группу grFirst и в группу grSecond...

Пользователь принадлежит одной группе. В таком случае какой смысл в нескольких коллекциях?

Все сделано точь-в-точь по инструкции, но при включении адаптера NLB-кластера перестают пинговаться шлюзы и прочие узлы сети. Куда копать?

Неправильно работает маршрутизация. Проверять конфигурацию сети.

http://technet.microsoft.com/ru-ru/library/cc771300(v=WS.10).aspx

Уважаемый автор, как Вы это прокомментируйте? Вопрос касается в частности пунктов настройки NLB. Согласно мануалу, при использовании посредника сеансов,требуется в настройках портов параметра "Сходство" устанавливать значение "Нет". Вы же указываете, что нужно выбирать "Сходство" - "Один"

Дельное замечание. До этого мой NLB-кластер работал именно в таком режиме, как описано у меня в статье. Хотя по логике действительно более правильно использовать режим Filtering Mode - Multiple host - Affinity: None, как описано в приведённом Вами документе. Я поменял режим работы своего NLB, погоняю его так, и если не столкнусь ни с какими проблемами, то обязательно изменю содержимое статьи. Спасибо.

Здравствуйте Алексей. Хорошая статья, особенно если ни разу не разворачивал.

У меня есть несколько вопросов

1. Зачем создавать сертификат с: Client Authentication (1.3.6.1.5.5.7.3.2), Server Authentication (1.3.6.1.5.5.7.3.1) ? Должно быть достаточно Server Authentication (1.3.6.1.5.5.7.3.1), используются же такие же сертификаты как и в IIS.

2. Если мы создаем NLB кластера, то нам соответственно нужен сертификат на кластерное имя? Альтернативные вроде как и не нужны.

3. Объединение на каждом из хостов по несколько ролей (как то WI,CB,SH) это best practice? Или по возможности лучше распределить, типа WI, SG в DMZ, отдельные пара брокеров и Session Host?

1. Сейчас уже не вспомню, где находил информацию о таких OID. Могу точно сказать только то, что сейчас разворачиваю ферму RDS на Windows Server 2012 R2, и там использую сертификат только с Server Authentication и этого, вроде как, действительно достаточно.

2. Так и есть. В статье это упоминается.

3. Если позволяют ресурсы, то конечно лучше разделить роли.

Обратная ссылка: Windows Server 2012 R2 Remote Desktop Connection Broker — Невозможно подключиться к высоко-доступной ферме RDS — Подключение было запрещено… | Блог IT-KB /

Добрый день, Алексей! Огромное Вам спасибо за рекомендации и комментарии!

Конфигурацию сделал несколько другую - разделил роли. Сделал NLB кластер rdfarm0 из двух виртуальных серверов rdfarm0-0 и rdfarm0-1, на которых крутится session broker в высокодоступном режиме. Также есть два физических session hosts, из которых сделана session collection. Права доступа пользователей по rdp к серверам-членам этой коллекции дадены.

При попытке запуска mstsc /v:rdfarm0 и дальнейшего входа под обычным пользователем я ожидал, что сессия будет образована с одним из session host серверов. Однако, этого не происходит - выдается отлуп, глясящий, что обычный пользователь не имеет прав заходить по rdp на сервер rdfarm0-0 (или rdfarm0-1), что совершенно справедливо, т.к. таковых прав действительно нет и не планируется.

Сие поведение вызвало недоумение. Это, так сказать, by design, или я что-то не так понимаю?

Запланированная конфигурация такова - кластер из пары виртуальных брокеров на двух физически разных хостах + несколько (3-4) физических session hosts, на которых и работают сотрудники + отдельный виртуальный сервер лицензий.

Плиз, растолкуйте, если это Вас не затруднит!

Благодарю!

С увжаением, Константин.

Описанная в статье конфигурация работает, и работает по сей день. Но работает она только потому, что роли RDCB и RDSH совмещены на всех серверах. Вы меняете конфигурацию таким образом, что всё что описано в статье для Вас уже работать не будет. И как Вы понимаете, в этом нет ничего удивительного.

Попробуйте отказаться от NLB в пользу предлагаемой "бай дезайн" Round Robin DNS.

Почитайте последние заметки по RDS, и особенно эту: Windows Server 2012 R2 Remote Desktop Connection Broker — Невозможно подключиться к высоко-доступной ферме RDS — Подключение было запрещено…

Вполне возможно, что из неё Вы получите ответы на свои вопросы.

Добрый день.

При создании высоко-доступного RD Connection Broker выскакивает ошибка о невозможности подключения к SQL серверу. Все права и доступность через файл с расширением udl приверено, пишет что тест пройдет. Подскажите в какую сторону копать.

Осуждение ошибок возникших в вашем конкретном случае - на форуме.

Добрый день!

Вопрос возник, подскажите пожалуйста.

При открытии консоли управления Server Manager и выбора раздела Server Manager\Remote Desktop Services\Overview время от времени на главном поле вижу ошибку

"The Server pool dpes not match the RD Connection Brokers that are in it. Errors:

1.The RD Conenction Broker server test1.int.local is not in the server pool but is part of the cluster test.int.local. Add it the server pool"

Причем ферма построена из двух нод согласно Вашей статье. Доступ по RemoteAPP работает, тестовые выключения какой либо из нод это подтверждают.

Насколько я понимаю, консоль Вам просто сообщает о том, что в неё не добавлен какой-то один из серверов, входящих в ферму (в правом верхнем углу консоли Server Manager - Управление > Добавление серверов)

Так, да, решилось просто. Я создал в консоли группу RDS-FARM (хотя ранее и так создавал согласно статье).

Добавил в нее сервера фермы.

Странно.

Есть у меня маленькая проблема, на одном из серверов слетела цветовая схема, по-дефолту черный цвет области текста, надписей не видно. Где не рыл, но так и не смог найти решения проблемы. А переставлять сервер как-то не хочется.

Тоже сталкивались в своё время с подобной петрушкой. Лечилось только пересозданием профиля пользователя.

Дело как раз в том что профиль перемещаемый и на остальных серверах все хорошо, а на первом такая беда, профиль пересоздал, не помогло(

Временно лечу, применением через полиси темы которую создал. Причем если зайти под пользователем на раб. стол все хорошо но ексель или ворд - беда( Боюсь придется пересобрать ферму с новым сервером, благо уже создал и настроил. Хочу с тем же именем и тем же ИП. Как сделаю отпишусь о результатах.

Тут всё зависит от типа перемещаемости профиля. Если это классические Roaming Profiles + Redirected Folders, то ситуация одна, а если это User Profile Disk (UPD), то ситуация совсем иная. Есть подозрение, что в первом случае на каждом из терминальных серверов в локальной копии профиля несмотря на "перемещаемость" всё равно хранится часть данных уникальных для каждого такого сервера. Поэтому при удалении перемещаемого профиля и перенаправляемых папок из общей сетевой папки, дополнительно нужно выполнить удаление локального кэша профиля на каждом терминальном сервере и, возможно, только тогда проблема связанная с конкретным пользователем будет локализована. Если же используется UPD, то по сути достаточно лишь удалить vhd-образ профиля из общей сетевой папки.

Дополнительно из опыта общения с фермой RDS на Windows Server 2012 могу сказать что, там подобные странности - не редкость. Сейчас перешли на Windows Server 2012 R2 с UPD... пока наблюдаем за ситуацией.

Это классические Roaming Profiles + Redirected Folders. Удалял на нем(проблемном серваке) профиль юзера, и на сервере где профиля храняться тоже, не помогло)))

Такая же проблема на 12R2. Пришлось лечить включением Desktop Experience.

Desktop Experience помимо расширенных функций управления рабочим столом тянет за собой ряд компонент, излишних на мой взгляд для сервера RDS. Поэтому такое решение вопроса не рассматривалось вообще.

Здравствуйте! Подскажите можно ли как-то избавиться от черного фона в RDP сессии? Перепробовал уже, кажется, все. В том числе и Desktop Experience на серверах.

Спасибо.

Данная ферма в данной описанной схеме реализации у меня на пилоте была 3 месяца.

Что могу сказать : проявилась проблема плавающего отсутствия подключения клиентом из других подсетей. (филиалы)

Причем у пользователя может все работать сутками и неделями, а потом вдруг ошибка подключения (хотя инициализация соединения через ярлык происходит).

Проверка на маршрутизаторах показала что порты требуемые открыты. Со стороны пользователя порты к серверу доступны по telnet. Блокировок от спуффинга или иных филтров нет.

Набрел на статью (правда там о 2008): http://blogs.technet.com/b/networking/archive/2009/01/15/unable-to-connect-to-windows-server-2008-nlb-virtual-ip-address-from-hosts-in-different-subnets-when-nlb-is-in-multicast-mode.aspx

Сейчас задумываюсь о переходе на технологию DNS RR, ибо надо уже в пром заводить ферму.

Я использую Unicast NLB.

Виртуальные машины для статистики отказа переместил на один хост HYPER-V.

Я ушёл от описанной конфигурации на Windows Server 2012 R2 c DNS RR (в блоге есть более поздние записи об особенностях использования такой конфигурации) и в целом пока всё хорошо.

извините, я что то не смог найти это в блоге. не ткнете носом, если не сложно? :-)

нашел.

Видимо и меня так же ждет этот вариант.

Добрый день !

Вопрос относительно сертификатов. Для RDS созданы сертификаты доменным ЦС. OID стоят соответсвующие Client Authentication (1.3.6.1.5.5.7.3.2), Server Authentication (1.3.6.1.5.5.7.3.1).

В настройках сертификата указаны все используемые SAN серверов с ролями RDS. Сертификаты применены в настройках фермы.

По факту при запуске приложения из RD Web вылетает окно предупреждения, указан самоподписанный сертификат сервера, а не указанный в настройках фермы, подписанный выдающим ЦС.

Куда копать ? почему используется самоподписанный вместо указанного доменного ?

Спасибо.

Проверьте сертификат в IIS для вашего адреса на вэбсервере.

Обратная ссылка: Виртуализированная терминальная ферма NLB на базе Server 2012 R2 в режиме IGMP Multicast | Nixlie /

Алексей, добрый день! Не сталкивались ли вы с такой проблемой?.... Поднял ферму из двух серверов и кластера sql (always on). Делаю тесты на отказоустойчивость, но ферма отказывается нормально работать. т.е. если пользователь залогинился на одном из серверов и выключить этот сервер например отключив питаение, а не корректно завершив его работу, то этот пользователь не может попасть на другой сервер в ферме. Вроде бы подключается долго думает но потом выдаёт ошибку (удаленному рабочему столу не удалось подключиться к удаленному компьютеру по одной из следующих причин.....) Но если корректно сделать выход из системы и выключить терминальник правильно, то пользователь может зайти на другой и без проблем. Пробовал sql 2014 always on и без кластеризации и sql 2008 не помогло.

Используйте Windows Server 2012 R2 и рекомендованную MS конфигурацию с использованием DNS RR вместо NLB.

Да. кластер устанавливался на Windows Server 2012 R2 со всеми обновлениями и пробовал DNS RR.

Андрей, смогли побороть проблему? У меня аналогичная вам ситуация...Перепробовал все варианты.

то же самое. Кластер просто показывает что сеанс пользователя активен на том сервере который выключен и я вно пытается долбиться именно на него

>>Set-RDWorkspace -Name "Приложения RemoteApp" -ConnectionBroker KOM-AD01-RDS21.holding.com

а для Windows 2008R2 есть аналог?

Имя "Set-RDWorkspace" не распознано как имя командлета, функции, файла скрипта или выполняемой программы. Проверьте пра

вильность написания имени, а также наличие и правильность пути, после чего повторите попытку.

Здравствуйте Алексей, спасибо за труд, очень полезная страница. Удачи в будущем

Вопросы такие:

KOM-AD01-RDSNLB это у вас виртуальный адрес? Если правильно понял.

И в SQL кластере плюс две машины?

Всё верно.

Добрый Вечер Алексей.

После добавления второго Broker сервера в HA он автоматом будет работат в режиме HA?

Да.

Алексей а это нормально что на сервере где я создовал sessionsost ферму, так сказать вывеска видна RDS_FARM например а на втором sessionhost сервере ее нету.

Но когда создовал collection установка пошла на обоих sessionhost серверах.

https://www.dropbox.com/s/ewy35kocmi1wtwa/farmproblem.JPG?dl=0

RDS_FARM на Вашем скриншоте это всего лишь группа серверов созданная в консоли Server Manager. То есть, это простое логическое объединение нескольких серверов для отображения в консоли. Если Вам удобно, Вы можете создать такую группу и на втором сервере. В любом случае, управление параметрами фермы RDS выполняется через узел консоли "Remote Desktop Server"

Добрый день! А имеет ли значение расположение sessionsost и сonnectionbroker. могут ли они находиться в разных подсетях допустим sessionsost 10.10.10.10-13 сonnectionbroker 10.10.11.10. Сети объединены туннелем gre.

По идее не имеет. Брокер это же по сути просто учётчик сеансов и перенаправитель.

В тестовой среду столкнулся с ошибкой при попытке подключения к приложению. DNS запись устарела.

Здравствуйте Алексей, я установил 2 Broker и 3 Session Host сервера и один SQL, Broker сервера добавил в HA они у меня показывают High Availability, создаю collection с Session Host серверами с UPD дисками подключаюс профил юзера добавляется,вроде все нормально , но после перезагрузки всех серверов вход в Session Host серверы сопроваждется созданием Temprorary Profile и выходит вот такое.

https://www.dropbox.com/s/4b42ukcs6d90fbq/nocon.JPG?dl=0

P.S При инсталлировании ни одной ошибки не вышло.

Я не понимаю о чём Вы говорите. Пишите в форум http://forum.it-kb.ru/

В данной статье было:

"На следующем шаге определяемся с тем, хотим ли мы использовать новую технологию Windows Server 2012 – User profile disks (UPD), которая, как я понял, предлагается в качестве альтернативы механизму перемещаемых профилей — Roaming User Profiles. Новая технология подразумевает централизованное хранение файлов пользователя в отдельных VHD дисках, которые располагаются где-то на выделенном файловом ресурсе. В силу того, что на данный момент нет уверенности в стабильности работы данного механизма из-за полученной информации в обсуждении Windows Server 2012 RDS — [User Profile Disk] VS [Roaming Profiles + Folder Redirection] я решил пока не использовать данный функционал и поэтому он не будет рассмотрен в данной заметке."

И реально технология UPD дисков сырая, об ошибки уже известно давно, но она не исправлена.

Можно еще попытаться решить http://pei.com/2013/05/temporary-profiles-on-server-2012-rds/

А по принскрину: посмотрите, чтоб на вкладке "Все серверы" были добавлены все сервера задействованные в ферме.

Отличная статья. Спасибо, Алексей.

А не подскажете, изменится ли содержимое "строка подключения к базе данных", если инстанс SQL-сервера не стандартный?

Имя экземпляра можно указать в SQL-алиасе. Для наглядности: https://blog.it-kb.ru/wp-content/uploads/2014/05/image_thumb25.png

Спасибо, помогло.

Есть ещё вариант. Если у Вас именованный экземпляр SQL Server работает на нестандартном порту, например, 1433, то строка подключения может иметь следующий вид:

DRIVER=SQL Server Native Client 11.0;SERVER=TCP:SQLSERVER.holding.com,1433;Trusted_Connection=Yes;APP=Remote Desktop Services Connection Broker;DATABASE=RDS-Connection-BrokerПроверено на Windows Server 2012 R2

Еще один вопросик.

При загрузке файла сертификата *.cer в Personal/Registry сертификат появляется без ключа (открытый), соотв. и экспортировать его не получается. Можете что-нибудь подсказать?

В описании я не уделил отдельного внимания тому, что импортировать готовый сертификат нужно на том-же сервере, на котором до этого генерировался запрос на выдачу сертификата (то есть на том сервере RDS, где выполнялась команда CertReq –New RequestPolicy.inf RequestFile.req). Тогда сертификат в хранилище сертификатов на этой системе будет связан с закрытым ключом и после этого появится возможность его экспорта вместе с закрытым ключом для последующего распространения на другие хосты фермы RDS.

В Pending Requests сертификат действительно закрытый, но! При импорте выданного CA сертификата *.cer в Personal/Registry, из Pending Requests сертификат не исчезает.

Всем спасибо за участие и извините за беспокойство!

Проблема была из-за того, что рутовый сертификат не был добавлен в доверенные корневые центры сертификации.

Сем-ё-ё-ё-н Семёныч... :)

Сначала вам нужно экспортировать сертификат в формате pfx.

До выгрузки в pfx я как раз и не дошел. Сделал запрос в Root CA, получил от него сертификат. Загружаю его в Personal/Registry. Он загружается без ключика. Т.е. выгрузить в pfx уже не получится.

добрый день, как правильней поступить и как поведет себя ферма? Если я соберу кластер (для NLB), и создам в ферме несколько "коллекций" (конкретно 3) для разных групп пользователей. Есть в этом смысл или правильней создать несколько ферм? смогут ли различные пользователи подключаться к разным коллекциям по одному IP? поддерживает ли подобный функционал broker?

Из практики могу порекомендовать использовать не Windows Server 2012 RDS с NLB, а Windows Server 2012 R2 RDS c DNS RR. Разные коллекции, полагаю, нужно разносить по разным фермам.

Подскажите пожалуйста. А можно подключаться к RDS ферме через mstsc обычный не скачивая перед этим файлик подключения к ферме через вебку? Как-то вручную.

Добрый день! Столкнулся с такой проблемой:

Развернул ферму: 2 сервера (на каждом роли брокера + терминальные + web) все это с балансировкой через NLB. При тестировании, захожу через rdweb в приложение. Смотрю на каком сервере сеанс. Выключаю этот сервер и.... Переподключение не происходит. Подумал что проблема в NLB. Сделал аналогично то же самое через Round Robin DNS - проблема осталась. Решил что возможно проблема в том, что совмещены роли брокера и служб терминалов + web. Вынес брокера на отдельный сервер. Проблема остается...Есть идеи - из-за чего не происходит реконнект?

P.S. если закрыть зависшее RemoteApp приложение которое не перепоключилось - то новое уже не открывается или висит в окне Добро пожаловать... Так же в оснастке СОЕДИНЕНИЯ на сервере-брокере, тот сеанс который я наблюдаю - всегда в статусе Активен.

Очень здорово написано.

Есть несколько комментариев, по опыту проектов по RDS

1) Roaming profiles это зло, они бьются. Лучше использовать новую возможность с профильными дисками для коллекций. Только для самого профиля. Остальное - folder redirection. Помогает оно еще и для Legacy Apps, которые хотят тупо букву диска.

2) Несколько RDWA это круто, но редактировать их отдельно неудобно, вероятность расхождения. Вижу два варианта - DFS-R папки RDWeb, или же IIS Shared Configuration

3) Было бы очень здорово почитать ваше видение, как настраивать RemoteFX USB Redirection для ферм RDSH.

В целом по изложенному могу сказать, что в конечном итоге ушёл от такой конфигурации в силу разных причин (ранее писал уже в комментариях). Сейчас используем ферму Windows Server 2012 R2 с родным DNS RR (без NLB), и в целом всё работает успешно.

1. За несколько лет эксплуатации Roaming profiles (с 2008 R2 до 2012) на ферме примерно с 600 профилями проблемы были всего пару раз, и то по причине человеческого фактора. Никаких претензий к этой технологии у меня особых не было. UPD тоже хорошая вещь, - год уже юзаем на 2012 R2 - полёт нормальный.

2. Ну это кому как нравится. Сами RDWA не так уж и часто правятся для того, чтобы утяжелять всю конструкцию ещё и такими вещами как DFS-R/IIS Shared Configuration внося при этом дополнительные компоненты потенциального отказа.

3. Не имел дела с RemoteFX (не было надобности).

Спасибо.

По 1 согласен, дело предпочтений. Сложность с профилми возникает когда ферм много, возникает масса лишнего в реестре. В моих масштабах я пришел к Profile Disks + UE-V

По 3 - понимаю, что копать корявую технологию дело неблагодарное. Мне потребовалось у двух заказчиков реализовывать проброс ключей (госзакупки и eToken) в терминальные приложения. Это нетривиально и нигде не описано отдельно от VDI, но работает.

Соответственно подхожу к 2. Тут хотел бы запросить мнения. У меня проект по миграции нескольких ферм XenApp 4.x/5.x на среду WS2012R2 - и пока не ясно справимся ли RDS+APP-V+UE-V или таки будет XenApp 7.6. Пользователей ферм немногим более 150000. Серверов Citrix сейчас около 5000. К новому проекту требование сократить в 10-20 раз за счет более мощных ВМ и масштабируемости новой ОС. Соответственно, говоря о настройке пяти RDSWA я готов делать руками, но если их тысяча(и)? И некоторые хотфиксы меняют настройки RDWeb, - как потом руками править? Оттого и идут мысли про DFS.

Но еще больше мыслей все же о выносе RDMS/RDCB/RDWA отдельно от самих RDSH. Расскажите предысторию, почему пришли к совмещению ролей? И до какого количества серверов вы бы и далее рекомендовали расширять данную архитектуру.

4. Отдельный вопрос возник по лицензированию SQL. Я правильно понимаю, что RDCB является аггрегатором, и SQL CAL нужен на каждый RDCB? Пробую посчитать, начиная с какого количества серверов в прошлом вопросе это становится уже дороже чем 2/3 выделенных сервера управления (ОС бесплатна, ибо внизу датацентр, так что цена это вопрос ресурсов и обслуживания)

Хотите поговорить, пишите пожалуйста на форум http://forum.it-kb.ru/viewforum.php?f=4, чтобы не захламлять комментарии, а то здесь их итак уже с избытком.

Алексей, в статье указано:

>В силу того, что на данный момент нет уверенности в стабильности работы данного механизма из-за >полученной информации в обсуждении Windows Server 2012 RDS — [User Profile Disk] VS [Roaming Profiles >+ Folder Redirection] я решил пока не использовать данный функционал и поэтому он не будет рассмотрен >в данной заметке.

а в комментарии пишите:

>UPD тоже хорошая вещь, — год уже юзаем на 2012 R2 — полёт нормальный.

Как-то решается проблема с залоченными UPD файлами? У меня на ферма из 4 серверов (1 шлюз+брокер (на нем сетевой ресурс с UPD) и 3 rds). Включены и перемещаемые каталоги.

Так проблема воспроизводилась практически со 100% вероятностью, если пользователь залогинен в ферме и в этот момент перегрузить сервер на котором UPD либо отключить питание у сервера,.

Никто не сталкивался с проблемой описаной мной выше?

2 сервера (на каждом роли брокера + терминальные + web) все это с балансировкой через NLB. При тестировании, захожу через rdweb в приложение. Смотрю на каком сервере сеанс. Выключаю этот сервер и…. Переподключение не происходит. Подумал что проблема в NLB. Сделал аналогично то же самое через Round Robin DNS — проблема осталась. Решил что возможно проблема в том, что совмещены роли брокера и служб терминалов + web. Вынес брокера на отдельный сервер. Проблема остается…Есть идеи — из-за чего не происходит реконнект?

P.S. если закрыть зависшее RemoteApp приложение которое не перепоключилось — то новое уже не открывается или висит в окне Добро пожаловать… Так же в оснастке СОЕДИНЕНИЯ на сервере-брокере, тот сеанс который я наблюдаю — всегда в статусе Активен.